\\ Home Page : Pubblicazioni

Di seguito gli articoli e le fotografie pubblicati nella giornata richiesta.

Articoli del 14/01/2026

Di Alex (pubblicato @ 13:00:00 in Tecnologia, letto 7 volte)

Le Huawei FreeBuds SE 2 garantiscono 40 ore di musica e comfort totale

Scopri la libertà con Huawei FreeBuds SE 2, che garantiscono fino a 40 ore di riproduzione. Design ergonomico, ricarica rapida e connessione Bluetooth 5.3 stabile per un audio senza interruzioni e comodità assoluta. LEGGI TUTTO L'ARTICOLO

SOTTO 29€

🛒 Compralo ora su

|

Lunga durata in formato compatto

Huawei ha puntato tutto sull'efficienza con le FreeBuds SE 2. La custodia di ricarica compatta nasconde una riserva di energia che porta l'autonomia totale a ben 40 ore. Gli auricolari, singolarmente, offrono 9 ore di ascolto continuato. Inoltre, la tecnologia di ricarica rapida permette di ottenere 3 ore di musica con soli 10 minuti di permanenza nella custodia, un risultato eccellente per la categoria.

Stabilità e Comfort

Il protocollo Bluetooth 5.3 assicura una connessione robusta e a bassa latenza, sincronizzando perfettamente audio e video durante la visione di film o serie TV. Il design semi-in-ear è studiato per adattarsi all'orecchio esterno senza creare pressione, rendendole ideali per chi non ama gli auricolari in-ear intrusivi. La certificazione IP54 le protegge da polvere e schizzi.

- Autonomia Estesa: 40 ore totali con custodia, 9 ore singole.

- Ricarica Rapida: 3 ore di ascolto in 10 minuti.

- Connettività: Bluetooth 5.3 per stabilità e bassa latenza.

- Protezione: Resistenza IP54 a polvere e schizzi.

Le Huawei FreeBuds SE 2 sono la soluzione definitiva per chi cerca auricolari affidabili, leggeri e instancabili per accompagnare ogni giornata.

Di Alex (pubblicato @ 11:00:00 in Nuovi materiali, letto 24 volte)

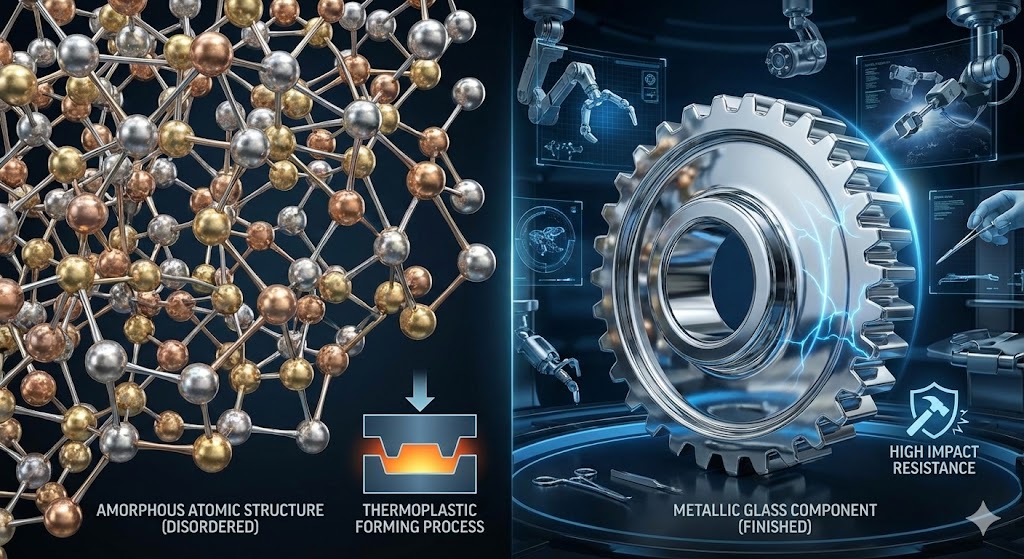

Struttura amorfa del vetro metallico con proprietà meccaniche straordinarie

Il vetro metallico rappresenta una delle innovazioni più affascinanti nella scienza dei materiali. Si tratta di leghe metalliche con struttura atomica amorfa, prive dell'ordine cristallino tipico dei metalli tradizionali. Questa caratteristica conferisce resistenza straordinaria e la possibilità di essere stampato come la plastica. LEGGI TUTTO L'ARTICOLO

Cos'è il vetro metallico e come si forma

Il vetro metallico, noto anche come metallic glass o lega amorfa, è un materiale che sfida le convenzioni della metallurgia classica. Mentre i metalli ordinari hanno una struttura cristallina ordinata, il vetro metallico presenta un arrangiamento atomico disordinato, simile a quello del vetro comune. Questa struttura si ottiene attraverso un rapidissimo raffreddamento della lega fusa, che impedisce agli atomi di organizzarsi in una struttura cristallina.

Il processo di produzione richiede velocità di raffreddamento estremamente elevate, dell'ordine di migliaia di gradi al secondo. Questo blocca gli atomi in una configurazione casuale, creando un materiale privo di difetti cristallini come dislocazioni e bordi di grano, tipici cause di debolezza nei metalli convenzionali. Le leghe più comuni utilizzate per produrre vetri metallici includono combinazioni di zirconio, titanio, rame, nichel e alluminio.

Proprietà meccaniche eccezionali

Le caratteristiche del vetro metallico lo rendono superiore ai metalli tradizionali in numerosi aspetti. L'assenza di difetti cristallini conferisce una resistenza meccanica eccezionale, con valori di durezza e limite elastico molto superiori a quelli dell'acciaio. Allo stesso tempo, il materiale mantiene una certa flessibilità elastica prima della rottura.

Le principali proprietà includono:

- Resistenza alla trazione fino a tre volte superiore all'acciaio ad alta resistenza

- Elevata resilienza e capacità di assorbire energia senza deformarsi permanentemente

- Eccellente resistenza alla corrosione e all'ossidazione

- Resistenza all'usura superiore rispetto ai metalli cristallini

- Capacità di essere stampato a caldo come materiale termoplastico

Quest'ultima caratteristica è particolarmente rivoluzionaria: sopra una certa temperatura, il vetro metallico diventa sufficientemente viscoso da essere modellato mediante stampaggio, consentendo la produzione di componenti complessi con tolleranze dimensionali estremamente precise.

Applicazioni nella robotica spaziale e nella medicina

La combinazione unica di proprietà del vetro metallico lo rende ideale per applicazioni estreme. Nella robotica spaziale, componenti realizzati in leghe amorfe offrono resistenza meccanica superiore e durabilità in ambienti ostili, resistendo alle radiazioni cosmiche e alle escursioni termiche dello spazio. La leggerezza relativa rispetto ai metalli tradizionali con pari resistenza rappresenta un ulteriore vantaggio per le missioni spaziali, dove ogni grammo conta.

Nel settore medico, il vetro metallico trova impiego nella produzione di strumenti chirurgici, impianti ortopedici e componenti per dispositivi medici. La resistenza all'usura garantisce una durata prolungata degli strumenti, mentre la biocompatibilità di alcune leghe specifiche le rende adatte per applicazioni a contatto con il corpo umano. Le proprietà antibatteriche superficiali di certi vetri metallici rappresentano un ulteriore beneficio per la prevenzione delle infezioni.

Sfide e prospettive future

Nonostante le proprietà eccezionali, il vetro metallico presenta ancora alcune limitazioni. La principale riguarda le dimensioni: produrre componenti di grandi dimensioni con struttura completamente amorfa rimane tecnicamente difficile e costoso. La maggior parte delle applicazioni attuali si concentra su componenti relativamente piccoli o rivestimenti superficiali.

Un'altra sfida è rappresentata dalla fragilità catastrofica: quando il vetro metallico raggiunge il punto di rottura, tende a fratturarsi improvvisamente senza deformazione plastica significativa. I ricercatori stanno sviluppando compositi ibridi che combinano vetri metallici con altri materiali per migliorare la tenacità alla frattura mantenendo le proprietà di resistenza.

Il vetro metallico rappresenta un esempio straordinario di come la manipolazione della struttura atomica possa generare materiali con caratteristiche rivoluzionarie. Con il progredire della ricerca e l'ottimizzazione dei processi produttivi, le leghe amorfe sono destinate a svolgere un ruolo sempre più importante nelle tecnologie avanzate, dall'esplorazione spaziale alla medicina di precisione.

Di Alex (pubblicato @ 09:00:00 in Tecnologia, letto 21 volte)

La piramide di Micerino con il suo caratteristico rivestimento in granito rosso

Eretta sulla piana di Giza intorno al 2510 a.C., la piramide di Micerino rappresenta un capolavoro di ingegneria che sfida ancora oggi la nostra comprensione. Con il suo rivestimento inferiore in granito rosso di Aswan e blocchi che raggiungono le 220 tonnellate, questa struttura testimonia le straordinarie capacità tecniche dell'antico Egitto. LEGGI TUTTO L'ARTICOLO

Le dimensioni e la posizione nella necropoli

Con un'altezza originale di 65 metri e una base di 108 metri per lato, la piramide di Micerino è la più piccola delle tre grandi piramidi della piana di Giza. Nonostante le dimensioni ridotte rispetto a quelle di Cheope e Chefren, la struttura occupa una posizione strategica nel complesso funerario, completando l'allineamento astronomico che caratterizza l'intera necropoli.

La scelta di costruire una piramide di dimensioni inferiori non riflette un declino delle capacità costruttive, ma piuttosto un cambiamento nelle priorità religiose e architettoniche della IV dinastia. Gli studiosi ipotizzano che Micerino abbia preferito investire risorse nella qualità dei materiali e nella perfezione della lavorazione piuttosto che nelle dimensioni monumentali.

Il rivestimento in granito rosso di Aswan

L'elemento più distintivo della piramide di Micerino è senza dubbio il rivestimento dei sedici filari inferiori in granito rosso proveniente dalle cave di Aswan, situate a oltre 800 chilometri di distanza. Questo materiale, estratto e trasportato lungo il Nilo, conferiva alla struttura un aspetto cromatico unico, creando un contrasto visivo con il calcare bianco utilizzato per i livelli superiori.

Il granito rosso non era solo una scelta estetica: questo materiale estremamente duro e resistente garantiva una protezione superiore alla base della piramide contro l'erosione e i danni strutturali. La lavorazione del granito richiedeva tecniche specializzate e utensili specifici, probabilmente realizzati in rame indurito con l'aggiunta di arsenico, insieme all'uso di abrasivi come la sabbia di quarzo.

Tracce del rivestimento originale sono ancora visibili oggi, offrendo una testimonianza preziosa dell'aspetto originario della piramide. Gli archeologi hanno documentato la precisione millimetrica con cui i blocchi di granito venivano tagliati e posizionati, con giunture così strette che non permettevano l'inserimento di una lama di coltello.

Il tempio mortuario e i blocchi monumentali

Il tempio mortuario di Micerino, situato sul lato orientale della piramide, rappresenta uno dei complessi architettonici più impressionanti dell'antico Egitto. La struttura ospita blocchi di granito e calcare di dimensioni straordinarie, alcuni dei quali raggiungono un peso stimato di 220 tonnellate, classificandoli tra i massi più pesanti mai utilizzati nell'architettura egizia.

Il trasporto e il posizionamento di questi megaliti costituiscono ancora oggi uno degli enigmi più affascinanti dell'archeologia. Gli studiosi hanno proposto diverse teorie:

- L'utilizzo di rampe inclinate e slitte di legno lubrificate con acqua o olio

- Sistemi di leve e fulcri per sollevare progressivamente i blocchi

- Tecniche di rotolamento su tronchi cilindrici

- Possibile impiego di contrappesi e argani primitivi

Esperimenti archeologici moderni hanno dimostrato che squadre di centinaia di operai, coordinati da sovrintendenti esperti, avrebbero potuto spostare questi blocchi utilizzando tecniche basate su principi fisici semplici ma applicati con straordinaria efficienza. L'organizzazione logistica necessaria per questo tipo di lavoro presupponeva una società altamente strutturata, con capacità avanzate di pianificazione e gestione delle risorse umane.

Le camere interne e il sarcofago

L'interno della piramide di Micerino presenta un sistema di camere e corridoi che differisce significativamente da quello delle piramidi precedenti. L'ingresso, posto sul lato nord secondo la tradizione, conduce a un corridoio discendente che penetra nel corpo roccioso su cui poggia la piramide.

La camera sepolcrale, scavata nella roccia naturale e successivamente rivestita in granito, ospitava originariamente un magnifico sarcofago in basalto decorato con una facciata a palazzo. Questo prezioso manufatto, scoperto nel 1837 dall'esploratore britannico Richard Vyse, venne purtroppo perduto durante il trasporto via mare verso l'Inghilterra quando la nave Beatrice naufragò al largo delle coste spagnole nell'ottobre del 1838.

Le iscrizioni e i rilievi rinvenuti nelle camere interne forniscono preziose informazioni sui rituali funerari e sulle credenze religiose dell'epoca. Particolare interesse suscitano i testi che descrivono il viaggio del faraone nell'aldilà e la sua trasformazione in una divinità astrale.

Le piramidi satelliti e il complesso funerario

A sud della piramide principale si trovano tre piramidi satelliti più piccole, tradizionalmente attribuite alle regine di Micerino. Queste strutture, sebbene di dimensioni ridotte, presentano caratteristiche architettoniche sofisticate e costituiscono parte integrante del complesso funerario.

Il complesso include anche una via processionale che collegava il tempio mortuario al tempio a valle, situato ai margini della piana alluvionale del Nilo. Questa strada cerimoniale, lunga circa 600 metri, era utilizzata durante i rituali funebri e le celebrazioni religiose in onore del faraone defunto.

Gli scavi archeologici hanno rivelato l'esistenza di laboratori, magazzini e abitazioni per i sacerdoti addetti al culto funerario, dimostrando come il complesso piramidale fosse un centro religioso ed economico attivo per generazioni dopo la morte del sovrano.

Le tecniche costruttive e l'organizzazione del lavoro

La costruzione della piramide di Micerino richiese un impegno colossale in termini di manodopera, risorse e tempo. Le stime moderne suggeriscono che il progetto abbia impiegato tra i 10.000 e i 20.000 lavoratori per un periodo di circa 20-25 anni, anche se alcuni studiosi propongono cronologie più brevi.

A differenza della concezione tradizionale che vedeva gli schiavi come principale forza lavoro, le ricerche archeologiche degli ultimi decenni hanno dimostrato che i costruttori erano lavoratori salariati, organizzati in squadre specializzate. I villaggi operai scoperti nelle vicinanze delle piramidi hanno rivelato strutture abitative dignitose, forni per la produzione di pane, impianti per la lavorazione del rame e persino ospedali da campo per curare gli infortuni.

La logistica necessaria per alimentare e sostenere questa forza lavoro era impressionante: si stima che fossero necessarie diverse tonnellate di cibo al giorno, principalmente pane, birra, cipolle e occasionalmente carne. L'approvvigionamento di queste risorse richiedeva una rete di produzione e distribuzione efficiente, gestita dall'amministrazione centrale dello stato.

Gli studi moderni e le nuove scoperte

Le tecnologie moderne hanno permesso di approfondire la conoscenza della piramide di Micerino senza ricorrere a scavi invasivi. La muografia, tecnica che utilizza i muoni cosmici per "radiografare" le strutture, ha rivelato l'esistenza di possibili cavità interne finora sconosciute, aprendo nuove prospettive per la ricerca.

Analisi geofisiche con georadar e tomografie sismiche hanno mappato con precisione la struttura interna della piramide e le fondazioni, confermando l'estrema accuratezza con cui gli antichi costruttori livellarono il terreno roccioso prima di iniziare l'edificazione. Le variazioni di densità rilevate suggeriscono l'utilizzo di tecniche costruttive differenziate per le varie sezioni della piramide.

Studi recenti sui materiali hanno identificato la provenienza esatta delle pietre utilizzate, tracciando una mappa dettagliata delle cave sfruttate durante la costruzione. Queste ricerche hanno permesso di ricostruire le rotte di trasporto e di comprendere meglio l'organizzazione territoriale dell'antico regno.

La piramide di Micerino continua a stupire ricercatori e visitatori con la sua eleganza architettonica e le sue soluzioni tecniche innovative. Ogni nuova scoperta archeologica aggiunge un tassello alla comprensione di questa straordinaria civiltà, dimostrando come l'antico Egitto rappresentasse uno dei vertici dell'ingegno umano. Il rivestimento in granito rosso e i blocchi monumentali del tempio mortuario rimangono testimonianze tangibili di un'epoca in cui l'ambizione costruttiva si coniugava con una maestria tecnica che ancora oggi fatica a trovare spiegazioni definitive.

Di Alex (pubblicato @ 07:00:00 in Tecnologia, letto 45 volte)

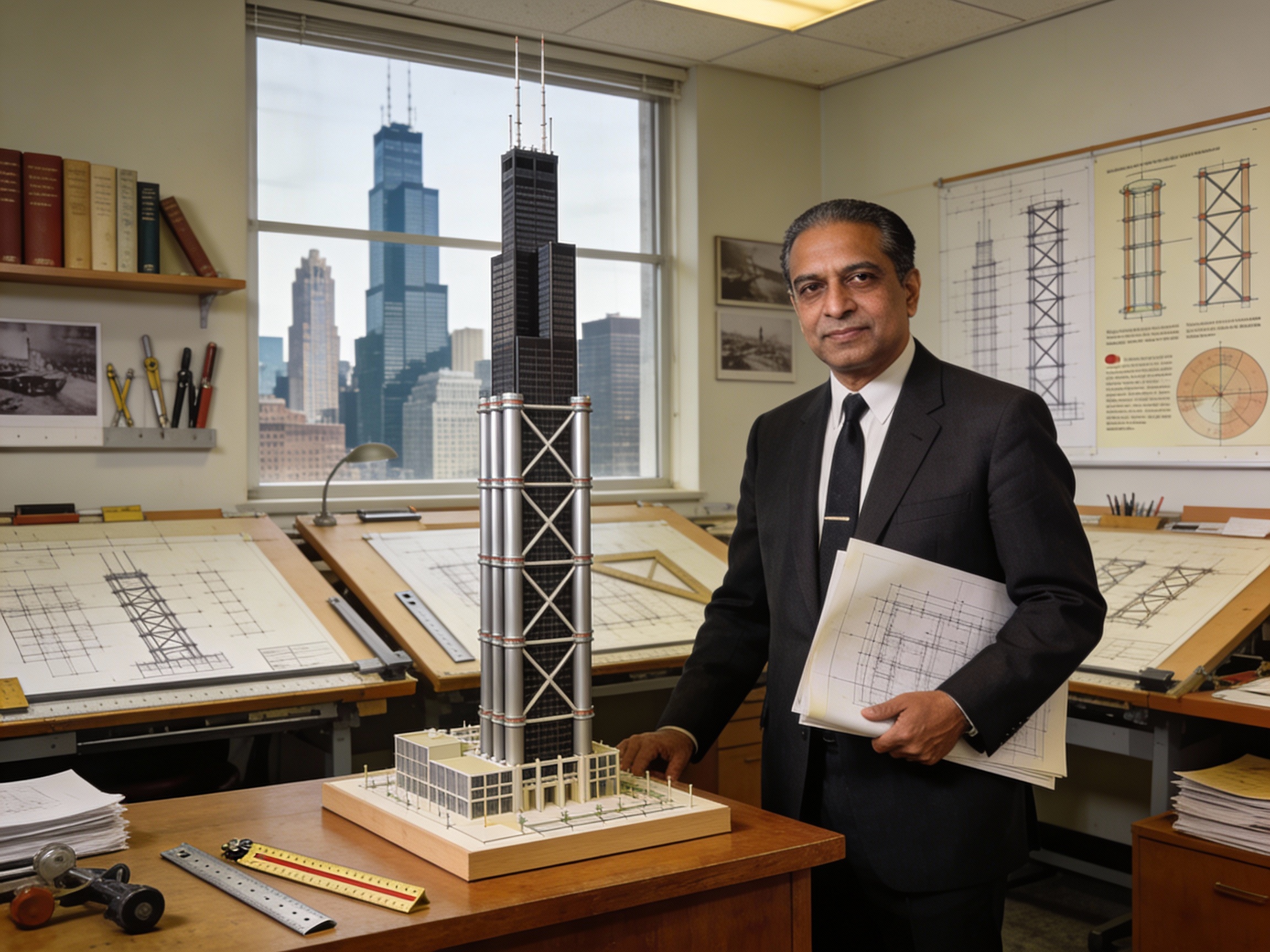

Fazlur Rahman Khan con un modello architettonico della Willis Tower

Un ingegnere visionario del Bangladesh ha cambiato per sempre lo skyline delle città moderne. Fazlur Rahman Khan ha inventato il sistema strutturale a tubo, permettendo la costruzione di grattacieli sempre più alti ed efficienti, come la Willis Tower e il John Hancock Center di Chicago. LEGGI TUTTO L'ARTICOLO

L'uomo che ha reso possibile le città nel cielo

Nato il 3 aprile 1929 a Dhaka, nell'attuale Bangladesh, Fazlur Rahman Khan è considerato il padre dei grattacieli moderni. Dopo essersi laureato in ingegneria civile, nel 1952 arrivò negli Stati Uniti con una borsa di studio Fulbright. All'Università dell'Illinois completò in soli tre anni due master e un dottorato, un risultato straordinario che anticipava il suo genio innovativo.

Nel 1955 entrò a far parte dello studio di architettura Skidmore, Owings & Merrill a Chicago, dove avrebbe rivoluzionato l'ingegneria strutturale. La sua filosofia andava oltre la pura tecnica: credeva che gli ingegneri dovessero avere una visione più ampia della vita, apprezzando l'arte, la musica e soprattutto le persone. È stato definito l'Einstein dell'ingegneria strutturale e il più grande ingegnere strutturale del XX secolo.

La rivoluzione del sistema tubolare

Prima di Khan, i grattacieli erano costruiti con telai rigidi in acciaio che richiedevano enormi quantità di materiale e limitavano l'altezza raggiungibile. Khan ebbe un'intuizione geniale: guardando una canna di bambù acquistata in un negozio di fiori, comprese che la struttura più efficiente per un grattacielo era quella di un tubo.

Il suo sistema tubolare sposta i supporti strutturali dal centro dell'edificio al perimetro esterno, creando colonne ravvicinate lungo tutto il perimetro collegate da travi. Questo design rivoluzionario offre diversi vantaggi: riduce drasticamente la quantità di acciaio necessaria, aumenta la resistenza ai venti e ai terremoti, e libera gli spazi interni dalle colonne, permettendo una maggiore flessibilità nella disposizione degli ambienti.

Il primo edificio a utilizzare questa tecnologia fu il Plaza on DeWitt nel 1966, un edificio di 43 piani a Chicago. Il sistema si rivelò così efficace che da allora la maggior parte degli edifici oltre i 40 piani costruiti nel mondo utilizza varianti del concetto tubolare di Khan.

Le icone architettoniche: John Hancock Center e Willis Tower

Nel 1969 Khan completò il John Hancock Center, un grattacielo di 100 piani con un sistema a tubo rinforzato da travi incrociate a X visibili sulla facciata esterna. Questa innovazione, oltre a rendere l'edificio iconico dal punto di vista estetico, lo rese incredibilmente efficiente: richiedeva solo 145 chilogrammi di acciaio per metro quadrato, contro i 275 del Chase Manhattan Bank Building del 1961.

Ma il capolavoro assoluto di Khan arrivò nel 1973 con la Willis Tower, originariamente chiamata Sears Tower. Con i suoi 110 piani e 442 metri di altezza, fu l'edificio più alto del mondo per 25 anni, fino al 1998. Khan utilizzò un sistema a fascio di tubi, composto da nove tubi quadrati disposti in una matrice 3x3, con diversi tubi che si fermano a varie altezze, creando l'iconico profilo a gradini dell'edificio.

La Willis Tower ospita oltre 12.000 occupanti, ha circa 418.000 metri quadrati di spazio ed è servita da 104 ascensori. Il progetto fu talmente ambizioso che all'epoca molti pensavano fosse impossibile da realizzare, ma Khan dimostrò che costruire verso l'alto era la soluzione alla crescente necessità di spazio abitativo causata dall'esplosione demografica.

Un'eredità duratura nell'ingegneria mondiale

Khan fu citato cinque volte dall'Engineering News-Record tra coloro che servirono al meglio gli interessi dell'industria delle costruzioni, e nel 1972 ricevette il premio Man of the Year. Nel 1973 venne eletto alla National Academy of Engineering e ricevette dottorati honoris causa dalle università Northwestern, Lehigh e dal Politecnico Federale di Zurigo.

I suoi sistemi strutturali continuano a influenzare la costruzione di grattacieli in tutto il mondo. Edifici iconici come le Petronas Towers di Kuala Lumpur, la Bank of China Tower di Hong Kong e innumerevoli altri grattacieli devono la loro esistenza ai principi ingegneristici sviluppati da Khan.

Tragicamente, Khan morì prematuramente il 27 marzo 1982, a soli 52 anni, per un infarto durante un viaggio d'affari in Arabia Saudita. Il Council on Tall Buildings and Urban Habitat ha istituito in suo onore la Fazlur Khan Lifetime Achievement Medal, uno dei più prestigiosi premi nel campo dell'architettura dei grattacieli.

Fazlur Rahman Khan ha dimostrato che l'ingegneria non è solo calcolo e materiali, ma visione e umanità. Ha reso possibile che miliardi di persone vivano e lavorino nelle città nel cielo, trasformando per sempre il modo in cui costruiamo e abitiamo gli spazi urbani. La sua eredità continua a elevarsi verso il cielo in ogni metropoli del mondo.

Sotto 60€

🛒 Costruisci lo Skyline di Chicago

|

Fotografie del 14/01/2026

Nessuna fotografia trovata.

Think different!

Think different!

Microsmeta Podcast

Microsmeta Podcast Feed Atom 0.3

Feed Atom 0.3

(p)Link

(p)Link Commenti

Commenti Storico

Storico Stampa

Stampa