\\ Home Page : Pubblicazioni

Di seguito gli articoli e le fotografie pubblicati nella giornata richiesta.

Articoli del 09/01/2026

Il celebre libretto che ha informato e istruito milioni di famiglie per quasi un secolo

Prima di Google, dei feed RSS e dei social media, c'era un piccolo libretto mensile che arrivava nelle case di tutto il mondo. Selezione dal Reader's Digest non era solo una rivista, ma un rivoluzionario sistema di "curatela dei contenuti" che ha anticipato l'era digitale di cinquant'anni. LEGGI TUTTO L'ARTICOLO

L'intuizione di DeWitt Wallace: condensare il sapere

Tutto iniziò nel 1922, quando DeWitt Wallace e sua moglie Lila Bell Acheson decisero di creare un periodico che non contenesse articoli originali, ma riassunti intelligenti dei migliori pezzi apparsi su altre pubblicazioni. L'idea era semplice quanto geniale: in un mondo che correva sempre più veloce, la gente aveva bisogno di informazioni preziose ma condensate. In Italia arrivò nel 1948, diventando subito un simbolo di modernità e di apertura verso il mondo scientifico e tecnologico americano.

Un'arma di informazione di massa

Selezione è stata fondamentale per la divulgazione medica e scientifica. Come qualche lettore canuto di allora ricorderà, è stata tra le prime testate a parlare apertamente di crisi sanitarie globali come l'AIDS quando erano ancora argomenti tabù. La rivista utilizzava un linguaggio che oggi definiremmo "SEO-friendly" ante litteram: titoli accattivanti, paragrafi brevi e storie umane capaci di creare una connessione emotiva con il lettore.

- Rubriche storiche come "Arricchite il vostro vocabolario" hanno alfabetizzato milioni di persone.

- Il formato tascabile permetteva di portarla ovunque, dal treno alla sala d'attesa, proprio come oggi facciamo con lo smartphone.

- Il sistema di abbonamento "fidelizzato" con i famosi concorsi a premi ha creato una delle prime grandi community globali.

Oggi che il cartaceo ha ceduto il passo al digitale, l'eredità di Selezione rivive nei nostri podcast e nelle nostre newsletter. Quella voglia di capire il mondo in pochi minuti è la stessa che ci spinge ogni giorno ad aggiornare il nostro Daily Digest.

Di Alex (pubblicato @ 17:00:00 in Nuovi materiali, letto 284 volte)

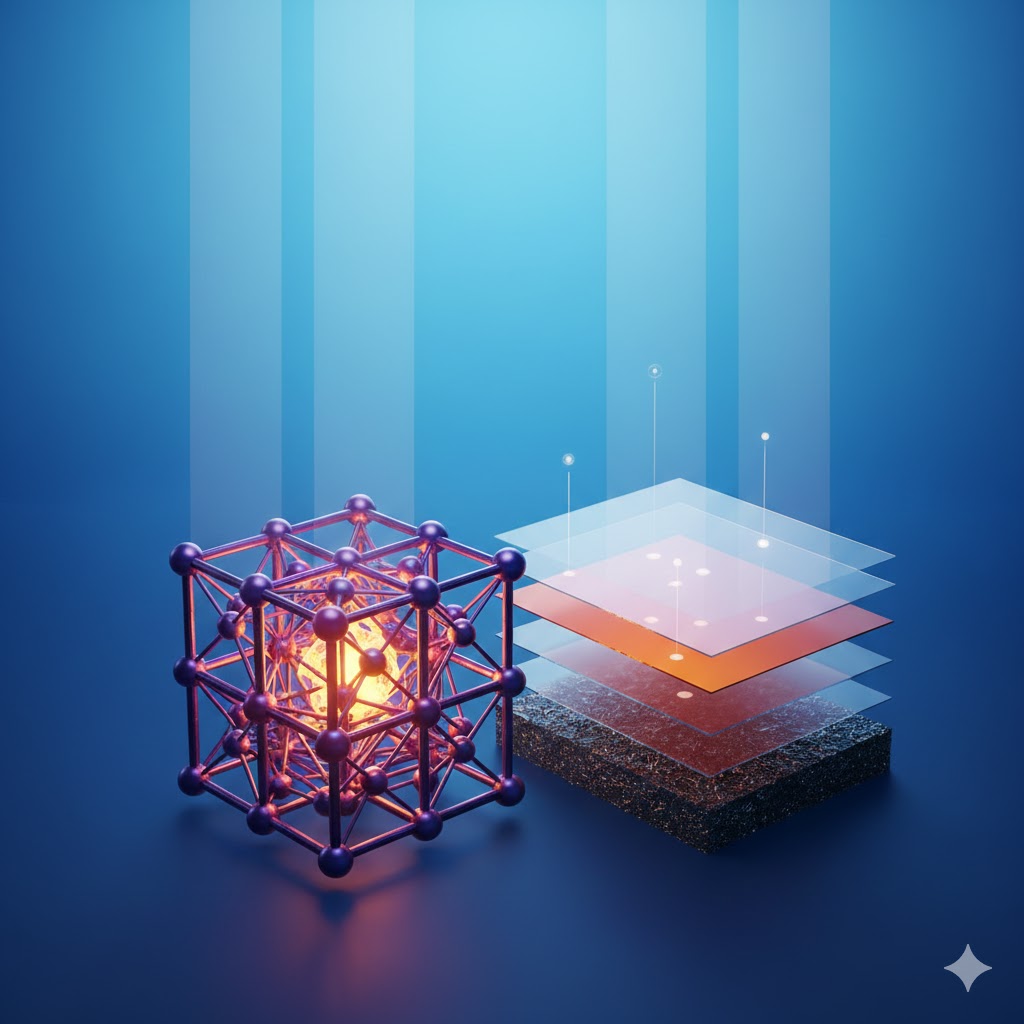

Celle solari a perovskite con struttura cristallina luminescente e celle tandem silicio-perovskite

Le celle solari a base di perovskite rappresentano la più promettente rivoluzione nel fotovoltaico degli ultimi trent'anni. Capaci di raggiungere efficienze superiori al silicio con costi di produzione drasticamente inferiori, queste celle potrebbero democratizzare l'energia solare. Tuttavia, un ostacolo fondamentale ne frena l'adozione: la loro instabilità chimica e strutturale. LEGGI TUTTO L'ARTICOLO

Cosa sono le perovskiti: una struttura cristallina rivoluzionaria

Il termine "perovskite" identifica originariamente un minerale, il titanato di calcio, scoperto nel 1839 negli Urali e nominato in onore del mineralogista russo Lev Perovski. Nel contesto fotovoltaico moderno, tuttavia, "perovskite" si riferisce non a un materiale specifico ma a un'intera famiglia di composti che condividono una particolare struttura cristallina con formula generale ABX₃.

La struttura perovskitica è geometricamente affascinante: un catione A di grandi dimensioni, tipicamente un catione organico come il metilamonio, occupa gli angoli di un cubo; al centro si posiziona un catione B metallico, solitamente piombo o stagno; mentre anioni X, generalmente alogenuri come iodio, bromo o cloro, occupano le facce del cubo formando ottaedri attorno al catione centrale. Questa architettura atomica conferisce proprietà optoelettroniche straordinarie.

Le perovskiti utilizzate per applicazioni solari sono materiali semiconduttori ibridi organici-inorganici. La composizione più studiata e performante è la metilamonio piombo triioduro, con formula CH₃NH₃PbI₃, spesso abbreviata come MAPbI₃. Questa particolare combinazione di elementi crea un materiale con un band gap ideale per assorbire la luce solare visibile e convertirla in elettricità con efficienza elevata.

Ciò che rende le perovskiti specialmente interessanti dal punto di vista scientifico è la loro "tolleranza ai difetti". A differenza del silicio cristallino, dove anche minuscole impurità degradano drasticamente le prestazioni, le perovskiti mantengono eccellenti proprietà elettroniche anche con concentrazioni significative di difetti nella struttura cristallina. Questo perché i difetti tendono a formarsi in stati energetici che non intrappolano i portatori di carica, permettendo agli elettroni e alle lacune generate dalla luce di muoversi liberamente e generare corrente.

La meteora ascesa: da zero al 26% di efficienza in un decennio

La storia delle celle solari a perovskite è straordinariamente recente e altrettanto straordinariamente rapida. Il primo utilizzo documentato di perovskiti in celle solari risale al 2009, quando ricercatori giapponesi guidati da Tsutomu Miyasaka svilupparono celle sensibilizzate con perovskite che raggiungevano appena il 3,8% di efficienza, utilizzando elettroliti liquidi. Queste prime celle erano instabili e si degradavano in pochi minuti.

Il vero punto di svolta avvenne nel 2012, quando gruppi di ricerca in Corea del Sud e Svizzera svilupparono indipendentemente celle solari "tutto-solido" usando perovskiti come assorbitore di luce principale, raggiungendo efficienze intorno al 9-10%. Da quel momento, la progressione è stata vertiginosa: 15% nel 2013, 20% nel 2014, oltre 22% nel 2016. Nel 2020 si superò il 25%, e attualmente il record certificato per celle singole a perovskite è di 26,1%.

Per contestualizzare questi numeri, il silicio cristallino ha impiegato decenni per passare dal 6% degli anni '50 all'attuale record di 26,7%. Le perovskiti hanno praticamente raggiunto lo stesso livello in circa dieci anni di ricerca intensiva. Questa velocità di miglioramento è senza precedenti nella storia della tecnologia fotovoltaica e ha generato un'ondata di entusiasmo nella comunità scientifica e industriale.

La ragione di questa ascesa fulminea risiede nella relativa semplicità di produzione e nella facilità di modifica della composizione chimica. A differenza del silicio, che richiede processi ad alta temperatura e vuoto spinto, le perovskiti possono essere depositate da soluzioni a temperatura ambiente o comunque moderata. Questo permette cicli di sviluppo estremamente rapidi: i ricercatori possono testare nuove composizioni, strutture di dispositivi e processi di fabbricazione in tempi brevissimi, accelerando l'ottimizzazione.

I vantaggi strutturali: perché le perovskiti superano il silicio

Il silicio cristallino domina il mercato fotovoltaico con oltre il 95% della quota, ma presenta limiti intrinseci che le perovskiti potrebbero superare.

Il coefficiente di assorbimento delle perovskiti è circa 10-100 volte superiore a quello del silicio. Questo significa che uno strato di perovskite spesso solo 300-500 nanometri è sufficiente per assorbire la maggior parte della luce solare utilizzabile, mentre il silicio richiede wafer di 150-200 micrometri. Meno materiale significa costi inferiori, peso ridotto e flessibilità applicativa.

Le perovskiti sono semiconduttori a gap diretto, il che significa che un fotone assorbito genera direttamente una coppia elettrone-lacuna senza bisogno di intermediari. Il silicio, essendo a gap indiretto, richiede anche un fonone per la transizione, riducendo l'efficienza di conversione. Questa proprietà rende le perovskiti intrinsecamente più efficienti nell'utilizzo dello spettro solare.

La lunghezza di diffusione dei portatori di carica nelle perovskiti di alta qualità supera il micrometro, nonostante lo spessore della cella sia submicrometrico. Questo significa che elettroni e lacune generati dalla luce riescono a raggiungere gli elettrodi prima di ricombinarsi, massimizzando la corrente estratta. Questa caratteristica è particolarmente notevole considerando che le perovskiti non richiedono drogaggio come il silicio.

Il band gap delle perovskiti è facilmente sintonizzabile modificando la composizione chimica. Sostituendo parzialmente lo iodio con bromo si può aumentare il gap, spostando l'assorbimento verso lunghezze d'onda più corte. Incorporando cesio o formamidinio al posto del metilamonio si possono ottenere strutture più stabili. Questa "ingegnerizzabilità" molecolare permette di ottimizzare il materiale per applicazioni specifiche.

Il tallone d'Achille: instabilità e degradazione

Nonostante le prestazioni straordinarie in laboratorio, le celle a perovskite affrontano un ostacolo fondamentale che ne ha finora impedito la commercializzazione su larga scala: la loro drammatica instabilità in condizioni operative reali.

L'umidità è il nemico numero uno. Le perovskiti a base di metilamonio piombo triioduro sono altamente igroscopiche: assorbono acqua dall'ambiente, che innesca una cascata di reazioni chimiche degradative. L'acqua reagisce con il gruppo metilamonio, causando la decomposizione della struttura perovskitica in precursori come l'ioduro di piombo e metilamina gassosa. Questo processo può essere devastante: celle non incapsulate esposte all'umidità ambientale possono degradarsi completamente in poche ore.

Il calore accelera ogni processo degradativo. Le temperature operative tipiche dei pannelli solari, che possono superare i 70-85°C nelle giornate estive, causano instabilità termica nelle perovskiti. A queste temperature, il metilamonio può evaporare dalla struttura, lo iodio può migrare formando difetti, e la fase cristallina può subire transizioni che alterano le proprietà optoelettroniche. Alcune composizioni di perovskiti ritornano a fasi cristalline non fotoattive sopra determinate temperature.

La luce stessa, ironicamente, danneggia le perovskiti attraverso meccanismi fotochimici. L'esposizione prolungata a illuminazione intensa, specialmente nelle componenti ultraviolette, può causare degradazione fotolitica. I fotoni ad alta energia possono rompere legami chimici, generare specie reattive che attaccano la struttura, e causare segregazione di fase in perovskiti a composizione mista. Questo fenomeno, noto come "photo-induced phase segregation", è particolarmente problematico nelle perovskiti a gap largo usate nelle celle tandem.

L'ossigeno, presente nell'aria, può ossidarsi con componenti della perovskite, particolarmente con gli alogenuri, formando composti volatili e degradando la struttura. In presenza simultanea di ossigeno, luce e umidità, i meccanismi degradativi si amplificano sinergicamente, accelerando il decadimento.

Gli stress meccanici, causati da cicli termici giorno-notte, espansione e contrazione di materiali con coefficienti diversi, vibrazioni, rappresentano un'ulteriore minaccia. Le perovskiti, essendo materiali relativamente morbidi con modulo di Young basso, possono sviluppare microfratture, delaminazioni e difetti estesi che fungono da centri di ricombinazione e percorsi per infiltrazione di agenti degradanti.

Strategie di stabilizzazione: dalla composizione all'incapsulamento

La comunità scientifica ha affrontato il problema dell'instabilità con un approccio multiplo, operando su diversi livelli: composizione chimica, ingegneria interfacciale, e incapsulamento protettivo.

Sul fronte compositivo, l'approccio "3D-passivation" sostituisce parzialmente il metilamonio organico con cationi inorganici più stabili come cesio e rubidio, e con cationi organici più grandi come formamidinio. Composizioni "triple-cation" come Cs₅MA₁₀FA₈₅Pb(I₀.₉Br₀.₁)₃ hanno dimostrato stabilità drasticamente migliorata mantenendo elevata efficienza. L'aggiunta di piccole quantità di bromo stabilizza la fase fotoattiva a temperature più alte.

La passivazione superficiale utilizza molecole organiche o strati inorganici ultra-sottili per "sigillare" la superficie delle perovskiti, bloccando l'infiltrazione di umidità e ossigeno e riducendo i difetti superficiali che fungono da centri di ricombinazione. Molecole come feniletilamonio, butilenamonio, o composti solfurati si legano alla superficie creando una barriera protettiva. Strati di ossidi metallici nanometrici come allumina depositata tramite atomic layer deposition forniscono protezione senza compromettere il trasporto di carica.

L'ingegneria dei layer di trasporto è cruciale. I materiali che estraggono elettroni e lacune dalla perovskite devono essere scelti non solo per efficienza ma per compatibilità chimica e stabilità propria. Ossidi metallici come biossido di titanio, ossido di stagno, ossido di nichel, opportunamente drogati e nanostrutturati, hanno sostituito i layer organici meno stabili delle prime generazioni.

L'incapsulamento rappresenta l'ultima linea di difesa. Le celle a perovskite devono essere sigillate ermeticamente da vetro, polimeri barriera, o laminati compositi che bloccano completamente infiltrazione di acqua e ossigeno. L'incapsulamento deve però rispettare requisiti stringenti: trasparenza ottica elevata, espansione termica compatibile, flessibilità se la cella deve essere flessibile, e naturalmente durata pluridecennale. Vetri ultra-sottili sigillati con sigillanti epossidici o butiliche, combinati con getter che assorbono tracce residue di umidità, rappresentano lo stato dell'arte.

Test di stress accelerati sotto protocolli standardizzati come IEC 61215 dimostrano che le migliori celle a perovskite attuali possono mantenere oltre il 90% dell'efficienza iniziale dopo 1000-2000 ore di test in condizioni estreme. Sebbene promettente, questo è ancora lontano dalle 25.000+ ore dimostrate dal silicio commerciale. La comunità scientifica ritiene realisticamente che stabilità commerciale verrà raggiunta nei prossimi 3-5 anni.

Le celle tandem silicio-perovskite: sinergia perfetta

Una delle applicazioni più entusiasmanti delle perovskiti non è come sostituto del silicio, ma come suo complemento nelle celle solari tandem. Questa configurazione rappresenta probabilmente la via più rapida verso la commercializzazione.

Le celle solari tradizionali a singola giunzione, che siano silicio o perovskite, affrontano un limite termodinamico fondamentale noto come limite di Shockley-Queisser, che fissa l'efficienza massima teorica intorno al 33% per un semiconduttore con gap ottimale di circa 1,34 eV. Questo limite deriva dal fatto che un singolo materiale non può utilizzare ottimalmente l'intero spettro solare: fotoni con energia inferiore al gap non vengono assorbiti, mentre l'energia in eccesso dei fotoni ad alta energia viene dissipata come calore.

Le celle tandem superano questo limite stratificando due o più celle con gap differenti. La cella superiore, con gap largo, assorbe fotoni ad alta energia blu-verdi e lascia passare quelli a bassa energia rosso-infrarossi, che vengono poi assorbiti dalla cella inferiore a gap stretto. Ogni fotone viene così utilizzato dal semiconduttore più appropriato, riducendo le perdite.

La combinazione silicio-perovskite è quasi ideale. Il silicio ha un gap di 1,12 eV, ottimale per la porzione infrarossa dello spettro. Le perovskiti possono essere ingegnerizzate per avere gap tra 1,60-1,80 eV, ideale per la porzione visibile. Questa coppia teoricamente può raggiungere efficienze del 35-40%, ben oltre il 26-27% delle migliori celle singole.

Esistono due architetture principali per celle tandem. Le celle "monolitiche" integrano entrambe le giunzioni in un singolo dispositivo depositato sequenzialmente, con layer di ricombinazione intermedi che connettono elettricamente le due sottocelle. Questo design è elegante e compatto ma tecnologicamente sfidante: richiede processi di deposizione della perovskite che non danneggino il silicio sottostante.

Le celle "meccanicamente impilate" fabbricano indipendentemente celle di silicio e perovskite, poi le uniscono mediante laminazione o adesione. Ogni sottocella può essere ottimizzata separatamente e ha i propri contatti elettrici. Sebbene più spessa e potenzialmente meno efficiente per perdite ottiche all'interfaccia, questa architettura è più flessibile e più vicina alla produzione industriale, poiché sfrutta l'infrastruttura esistente per celle al silicio.

I record di efficienza per tandem silicio-perovskite sono impressionanti. Nel 2023, ricercatori del Helmholtz-Zentrum Berlin hanno raggiunto il 32,5% di efficienza con una cella tandem monolitica, certificata da laboratori indipendenti. Altri gruppi hanno superato il 33% con configurazioni meccanicamente impilate. Questi risultati dimostrano la fattibilità tecnica dell'approccio.

Il percorso verso la commercializzazione delle tandem è più breve rispetto alle perovskiti pure. Aziende come Oxford PV, Tandem PV, Swift Solar stanno costruendo linee pilota e prevedono prodotti commerciali nel 2025-2026. Il vantaggio è chiaro: utilizzare l'infrastruttura produttiva del silicio già esistente, aggiungendo semplicemente il layer di perovskite, con un costo incrementale relativamente contenuto a fronte di un significativo aumento di efficienza che si traduce in più energia prodotta per metro quadro.

Applicazioni sottomarine: fotovoltaico nelle profondità

Un'applicazione inaspettata e affascinante delle celle a perovskite è la generazione di energia solare in ambienti sottomarini, un contesto estremo dove le proprietà uniche di questi materiali potrebbero offrire vantaggi decisivi.

La luce penetra nell'acqua marina con attenuazione dipendente dalla lunghezza d'onda. Le componenti rosse e infrarosse dello spettro sono assorbite molto rapidamente, praticamente scomparendo nei primi 10 metri. Le lunghezze d'onda blu e verdi penetrano molto più profondamente, raggiungendo centinaia di metri in acque limpide. A 10 metri di profondità, lo spettro solare è dominato dalla luce blu-verde tra 400-550 nanometri.

Le celle al silicio tradizionali sono ottimizzate per lo spettro solare superficiale e hanno risposta spettrale debole nella regione blu-verde. Le perovskiti, invece, possono essere ingegnerizzate specificamente per avere assorbimento massimo in questa banda. Perovskiti a gap largo, con incorporazione di bromo o cloro, hanno dimostrato efficienze sottomarine superiori rispetto al silicio nella stessa profondità.

Le applicazioni sono molteplici. Sensori sottomarini autonomi, attualmente alimentati da batterie con durata limitata, potrebbero operare indefinitamente con pannelli a perovskite. Stazioni di monitoraggio ambientale, plancton sampling, sismometri sottomarini, veicoli sottomarini autonomi potrebbero beneficiare di ricarica continua.

Acquacoltura in mare aperto rappresenta un settore in rapida espansione che necessita di energia per aerazione, monitoraggio, sistemi di alimentazione automatica. Gabbie galleggianti dotate di pannelli fotovoltaici sottomarini potrebbero operare completamente off-grid.

Le sfide sono significative. L'incapsulamento deve resistere a pressione idrostatica, salinità, biofouling. La pressione aumenta di 1 atmosfera ogni 10 metri; a 100 metri si raggiungono 11 atmosfere che possono comprimere materiali, infiltrare acqua attraverso microfratture, delaminare interfacce. Il sale marino è corrosivo per metalli e alcuni polimeri. Alghe, batteri, molluschi colonizzano superfici sommerse riducendo la trasmittanza luminosa.

Ricercatori cinesi e coreani hanno sviluppato prototipi con incapsulamento in vetro borosilicato ultra-resistente e sigillature metalliche saldate, dimostrando operazione stabile a 20-50 metri per settimane. Altri approcci utilizzano polimeri fluorurati idrorepellenti e rivestimenti anti-fouling ispirati alle superfici marine naturali.

Un vantaggio sottovalutato dell'ambiente sottomarino è il raffreddamento. L'acqua dissipa efficacemente il calore, mantenendo le celle a temperature inferiori rispetto a pannelli terrestri o galleggianti. Questo migliora l'efficienza e riduce la degradazione termica, potenzialmente estendendo la vita operativa delle perovskiti.

La questione del piombo: tossicità e alternative

Un problema spesso trascurato ma cruciale per l'accettabilità ambientale delle celle a perovskite è la presenza di piombo. Le composizioni più efficienti utilizzano piombo come catione metallico centrale, e ogni metro quadrato di pannello contiene circa 1 grammo di piombo.

Sebbene questa quantità sia relativamente piccola, la prospettiva di gigawatt di pannelli a perovskite comporterebbe tonnellate di piombo distribuito su tetti, campi, potenzialmente in ambienti sensibili.

Di Alex (pubblicato @ 15:00:00 in Storia delle invenzioni, letto 276 volte)

Evoluzione degli occhiali attraverso i secoli, dalle prime lenti medievali agli smart glasses moderni

Gli occhiali rappresentano una delle invenzioni più rivoluzionarie della storia umana, trasformando la vita di miliardi di persone. Dal XIII secolo ad oggi, questa tecnologia ha compiuto un viaggio straordinario: dalle prime rudimentali lenti di vetro alle moderne soluzioni elettroniche che promettono di ridefinire completamente il concetto di correzione visiva. LEGGI TUTTO L'ARTICOLO

Le origini medievali: quando il vetro divenne finestra sul mondo

La nascita degli occhiali si colloca nell'Italia del XIII secolo, precisamente tra Venezia e Firenze, cuori pulsanti della lavorazione del vetro. I primi dispositivi ottici erano semplici "pietre da lettura", sfere di vetro o cristallo di rocca che venivano appoggiate direttamente sui testi manoscritti per ingrandire le lettere. Questi strumenti primitivi erano utilizzati principalmente dai monaci amanuensi, che passavano ore a copiare testi religiosi in condizioni di scarsa illuminazione.

Il vero salto tecnologico avvenne intorno al 1290, quando artigiani veneziani svilupparono le prime lenti convesse montate su montature. Queste consistevano in due lenti di vetro soffiato, levigate manualmente e unite da un rivetto centrale che permetteva di bilanciarle sul naso. Il frate domenicano Giordano da Pisa, in un sermone del 1305, menzionò esplicitamente che "non sono ancora venti anni che si trovò l'arte di fare gli occhiali", confermando la datazione di questa invenzione agli ultimi decenni del XIII secolo.

La produzione di questi primi occhiali era estremamente complessa e costosa. Le lenti venivano ricavate da dischi di vetro soffiato, poi levigati con polveri abrasive su ruote di pietra. Il processo richiedeva settimane di lavoro per una singola coppia di lenti, rendendo gli occhiali un lusso accessibile solo a ricchi mercanti, nobili e alti prelati. La Repubblica di Venezia proteggeva gelosamente questi segreti artigianali, al punto che i vetrai di Murano erano obbligati a risiedere sull'isola per impedire la diffusione delle tecniche produttive.

L'espansione rinascimentale e le prime innovazioni strutturali

Durante il Rinascimento, l'uso degli occhiali si diffuse progressivamente in tutta Europa. L'invenzione della stampa a caratteri mobili di Gutenberg nel 1455 creò una domanda esplosiva di dispositivi per la lettura. Improvvisamente, non erano più solo i monaci a leggere intensivamente, ma mercanti, studiosi, funzionari e la nascente borghesia urbana.

Le montature subirono una rivoluzione strutturale. I primi modelli a "ponte", che si bilanciavano precariamente sul naso, vennero gradualmente sostituiti da soluzioni più stabili. Nel XVI secolo apparvero i primi occhiali con stanghette laterali che si appoggiavano alle tempie, anche se queste erano ancora rigide e scomode. I materiali si diversificarono: accanto al vetro, si sperimentarono montature in osso, corno, cuoio e metalli preziosi per i clienti più facoltosi.

Un'innovazione cruciale fu lo sviluppo delle lenti concave per la correzione della miopia, intorno alla metà del XVI secolo. Fino ad allora, gli occhiali correggevano esclusivamente la presbiopia, l'incapacità di mettere a fuoco da vicino tipica dell'età avanzata. Le lenti concave permettevano invece di vedere meglio da lontano, aprendo l'uso degli occhiali alle generazioni più giovani. Questa scoperta fu particolarmente importante per artisti, artigiani e soldati.

Il XVII e XVIII secolo videro l'affermarsi di mode e stili diversi. In Spagna divennero popolari gli "occhiali a forbice", con un manico laterale che permetteva di tenerli davanti agli occhi solo quando necessario. In Francia si diffusero i "lorgnon", occhiali senza stanghette tenuti in mano, considerati più eleganti. Gli occhiali divennero anche un simbolo di status sociale e intellettuale: indossarli significava appartenere alla classe colta e agiata.

La rivoluzione industriale e la democratizzazione della vista

L'Ottocento segnò una svolta epocale nella produzione e diffusione degli occhiali. La rivoluzione industriale introdusse macchinari per la molatura meccanica delle lenti, riducendo drasticamente i tempi di produzione e i costi. Le innovazioni metallurgiche permisero di creare montature più leggere e resistenti in acciaio e leghe di nichel.

Nel 1784, Benjamin Franklin inventò le lenti bifocali, una soluzione geniale per chi soffriva sia di miopia che di presbiopia. Queste lenti, divise orizzontalmente in due sezioni con poteri diottrici diversi, permettevano di vedere bene sia da vicino che da lontano senza dover cambiare occhiali. Questa invenzione rimase sostanzialmente invariata fino al XX secolo e rappresentò un modello di ingegnosità pratica.

Le stanghette moderne, flessibili e curve dietro le orecchie, si affermarono definitivamente a metà Ottocento. Questa configurazione, che oggi consideriamo ovvia, risolse finalmente il problema della stabilità: gli occhiali rimanevano saldamente in posizione durante i movimenti della testa, rendendo possibile indossarli durante attività fisiche.

La fine del XIX secolo vide anche i primi approcci scientifici all'optometria. L'oftalmologo olandese Herman Snellen sviluppò nel 1862 la famosa tabella per la misurazione dell'acuità visiva, ancora utilizzata oggi. In Germania, l'azienda Carl Zeiss, fondata nel 1846, applicò principi di ottica avanzata alla produzione di lenti di precisione, stabilendo standard qualitativi che trasformarono gli occhiali da semplici ausili a dispositivi medici calibrati scientificamente.

Il Novecento: materiali innovativi e design funzionale

Il XX secolo portò una rivoluzione nei materiali. Negli anni '40, l'introduzione delle resine plastiche CR-39 per le lenti rappresentò un balzo qualitativo enorme: erano più leggere del vetro, più resistenti agli urti e più facili da lavorare. Le montature in celluloide prima, e in acetato di cellulosa poi, permisero design colorati e forme audaci che trasformarono gli occhiali in accessori di moda.

Gli anni '50 e '60 videro l'esplosione commerciale degli occhiali da sole, che da strumenti di protezione per aviatori e sciatori divennero simboli di stile grazie a icone cinematografiche come Audrey Hepburn e James Dean. Ray-Ban, Persol e altre marche trasformarono gli occhiali in oggetti di desiderio, con design iconici che sono rimasti popolari per decenni.

Sul fronte correttivo, le lenti progressive rappresentarono negli anni '50 un'evoluzione delle bifocali: invece di una netta separazione, offrivano una transizione graduale tra le diverse zone di correzione, eliminando il "salto" visivo delle bifocali tradizionali. Questa tecnologia, perfezionata negli anni '70, divenne lo standard per la correzione della presbiopia.

Le lenti a contatto, sperimentate già nell'Ottocento in forme rudimentali e dolorose, divennero pratiche solo negli anni '70 con l'introduzione delle lenti morbidi in idrogel. Queste permisero a milioni di persone di abbandonare gli occhiali tradizionali, almeno per parte della giornata. Negli anni '90, le lenti a contatto giornaliere usa e getta risolsero i problemi di manutenzione e igiene, aumentando ulteriormente la loro popolarità.

I trattamenti delle lenti: dalla protezione UV agli antiriflessi

Parallelamente all'evoluzione dei materiali base, il XX secolo ha visto lo sviluppo di trattamenti superficiali sempre più sofisticati. I rivestimenti antiriflesso, sviluppati inizialmente per applicazioni militari durante la Seconda Guerra Mondiale, vennero applicati alle lenti oftalmiche negli anni '70. Questi rivestimenti multicustrato riducono drasticamente i riflessi luminosi, migliorando la visione notturna e l'uso di schermi digitali.

Le lenti fotocromatiche, che si scuriscono automaticamente alla luce solare, furono commercializzate da Corning negli anni '60. Queste lenti contengono molecole di alogenuro d'argento o composti organici che cambiano struttura quando colpiti dai raggi UV, diventando temporaneamente scure. Le versioni moderne reagiscono in pochi secondi e offrono protezione UV totale.

I trattamenti idrorepellenti e oleorepellenti, ispirati all'effetto loto osservato in natura, mantengono le lenti pulite più a lungo respingendo acqua, grasso e sporco. I rivestimenti antigraffio, basati su strati di silice o composti ceramici, hanno prolungato la durata delle lenti plastiche, storicamente più soggette a danneggiamento rispetto al vetro.

Le lenti per la luce blu, sviluppate negli ultimi due decenni, filtrano selettivamente le lunghezze d'onda blu-viola emesse da schermi LED, riducendo l'affaticamento visivo digitale. Sebbene il dibattito scientifico sull'effettivo beneficio sia ancora aperto, queste lenti sono diventate estremamente popolari nell'era degli smartphone e del lavoro al computer.

La chirurgia refrattiva: quando gli occhiali diventano obsoleti

Gli anni '90 hanno portato una rivoluzione che per molti ha reso gli occhiali completamente superflui: la chirurgia laser agli occhi. La tecnica LASIK, approvata dalla FDA nel 1998, utilizza un laser ad eccimeri per rimodellare la cornea, correggendo permanentemente miopia, astigmatismo e ipermetropia.

Il procedimento è sorprendentemente rapido: dopo aver creato un sottile lembo corneale, il laser rimuove tessuto in quantità microscopiche, modificando la curvatura della cornea in base alla correzione necessaria. L'intera operazione dura circa 15 minuti per entrambi gli occhi, e la maggior parte dei pazienti recupera una vista nitida entro 24 ore.

Milioni di persone in tutto il mondo hanno scelto questa soluzione, attratte dalla libertà dagli occhiali e dalle lenti a contatto. Tuttavia, la chirurgia LASIK non è adatta a tutti: cornee troppo sottili, gradi elevati di miopia, o condizioni come la sindrome dell'occhio secco possono costituire controindicazioni. Inoltre, non previene la presbiopia legata all'età, che colpisce tutti dopo i 40 anni.

Tecniche più recenti come la SMILE (Small Incision Lenticule Extraction) e la PRK (PhotoRefractive Keratectomy) offrono alternative per casi specifici. Le lenti intraoculari fachiche, impiantate chirurgicamente senza rimuovere il cristallino naturale, rappresentano una soluzione per miopie molto elevate non trattabili con laser.

Gli smart glasses: quando gli occhiali diventano computer

Negli ultimi 15 anni, gli occhiali hanno iniziato a trasformarsi da semplici dispositivi ottici a piattaforme computazionali indossabili. Google Glass, lanciato nel 2013, fu il primo tentativo mainstream di creare occhiali con realtà aumentata integrata. Sebbene il progetto consumer fallisse, aprì la strada a una nuova categoria di dispositivi.

Gli smart glasses attuali si dividono in diverse categorie. Alcuni, come i Ray-Ban Stories sviluppati da Meta in collaborazione con EssilorLuxottica, integrano fotocamere, microfoni e altoparlanti per catturare contenuti e comunicare, mantenendo un aspetto praticamente identico agli occhiali tradizionali. Altri, come Microsoft HoloLens e Magic Leap, puntano su esperienze di realtà aumentata immersiva, sovrapponendo ologrammi tridimensionali al mondo reale.

Apple Vision Pro, lanciato nel 2024, pur essendo tecnicamente un visore, ha spinto i confini di cosa sia possibile fare con dispositivi indossabili ottici. La sua capacità di adattare automaticamente la correzione visiva dell'utente attraverso inserti ottici personalizzati rappresenta un ponte tra occhiali correttivi tradizionali e dispositivi di realtà mista.

Diverse startup stanno sviluppando occhiali smart focalizzati specificamente sulla correzione visiva dinamica. L'idea è rivoluzionaria: invece di lenti fisse, utilizzare display o elementi ottici regolabili elettronicamente che si adattano in tempo reale alle esigenze visive dell'utente.

La correzione elettronica della vista: il futuro è già qui

La frontiera più avanzata nella tecnologia degli occhiali è rappresentata dalla correzione elettronica adattiva. Diverse tecnologie stanno convergendo verso questo obiettivo apparentemente fantascientifico.

Le lenti a cristalli liquidi rappresentano l'approccio più maturo. Funzionano sullo stesso principio degli schermi LCD: celle riempite di cristalli liquidi cambiano orientazione quando attraversate da corrente elettrica, modificando le proprietà ottiche della lente. Aziende come PixelOptics (ora fallita) e DeepOptics hanno sviluppato prototipi di occhiali elettronici che passano istantaneamente dalla correzione per lontano a quella per vicino, eliminando la necessità delle progressive.

Un'altra tecnologia promettente sono le lenti Alvarez, un sistema di due lenti con profili cubici complementari che, scorrendo lateralmente l'una rispetto all'altra, cambiano il potere diottrico complessivo. Alcuni prototipi utilizzano piccoli motori per automatizzare questo movimento in risposta alla distanza dell'oggetto osservato, rilevata tramite sensori o telecamere.

Le lenti a focus variabile basate su membrane fluide elastiche rappresentano un approccio biomimetico: una piccola pompa modifica la pressione di un fluido contenuto tra due membrane trasparenti, cambiandone la curvatura e quindi il potere diottrico. Queste lenti possono teoricamente coprire un range estremamente ampio di correzioni con un singolo dispositivo.

La startup israeliana Varifocals e la giapponese Mitsui Chemicals stanno sviluppando soluzioni basate su metacristalli ottici e materiali a indice di rifrazione variabile controllato elettricamente. Questi approcci potrebbero portare a occhiali sottili come quelli tradizionali ma con capacità di correzione dinamica.

Eye-tracking e autofocus: la visione che si adatta a te

Il vero salto qualitativo degli occhiali elettronici non è solo nella variabilità della correzione, ma nell'intelligenza del sistema. Gli occhiali del futuro prossimo integreranno sistemi di eye-tracking che determinano costantemente cosa l'utente sta guardando e a che distanza.

Telecamere infrarosse miniaturizzate, montate sulle stanghette o sulla montatura, tracciano i movimenti oculari con precisione submillimetrica. Algoritmi di machine learning analizzano questi dati per predire le intenzioni visive dell'utente e regolare preventivamente la correzione. Se l'utente sposta lo sguardo dal telefono in mano a un cartello stradale lontano, gli occhiali cambiano correzione durante il movimento saccadico, così che l'immagine sia già nitida quando l'occhio si fissa sul nuovo target.

Questa tecnologia promette di risolvere uno dei maggiori problemi delle lenti progressive: la necessità di muovere la testa per trovare la zona corretta della lente. Con occhiali autofocus, l'intera superficie delle lenti può fornire la correzione ottimale, indipendentemente da dove l'utente guarda.

Alcuni prototipi stanno anche esplorando la correzione di aberrazioni ottiche di ordine superiore, difetti visivi complessi che le lenti tradizionali non possono correggere. Questi includono aberrazioni sferiche, coma e astigmatismi irregolari che causano problemi come aloni, starburst e visione notturna ridotta. Lenti elettroniche con molteplici zone di correzione indipendenti potrebbero teoricamente compensare questi difetti in tempo reale.

Le sfide tecniche e i limiti attuali

Nonostante i progressi impressionanti, gli occhiali a correzione elettronica affrontano sfide significative che ne impediscono ancora l'adozione di massa.

- Autonomia energetica: i sistemi attuali consumano troppa energia. Le lenti a cristalli liquidi richiedono alimentazione continua, e le batterie necessarie per una giornata intera rendono gli occhiali pesanti e ingombranti. Le ricerche si concentrano su celle fotovoltaiche integrate nelle lenti e su sistemi di energy harvesting che catturano energia dal movimento o dal calore corporeo.

- Qualità ottica: molte tecnologie di lenti variabili introducono distorsioni, aberrazioni cromatiche o riducono la trasmittanza luminosa. Gli occhiali tradizionali con lenti di alta qualità trasmettono oltre il 99% della luce; alcuni prototipi elettronici scendono sotto l'85%, causando affaticamento visivo.

- Velocità di risposta: cambiare la correzione richiede tempo. Le lenti a cristalli liquidi impiegano 0,5-2 secondi per la transizione completa, troppo lento per un'esperienza fluida. Gli occhi umani compiono movimenti saccadici che durano 20-200 millisecondi; idealmente, la correzione dovrebbe cambiare in meno di 50 millisecondi.

- Costo: i prototipi attuali costano migliaia di euro, rendendo la tecnologia accessibile solo in contesti di ricerca o per applicazioni professionali specializzate. La produzione di massa e la standardizzazione potrebbero ridurre i costi, ma rimangono componenti intrinsecamente costosi come sensori, processori e display ottici.

- Durabilità e affidabilità: gli occhiali tradizionali sono dispositivi puramente ottici e meccanici, estremamente affidabili. Aggiungere elettronica introduce punti di guasto: batterie che si degradano, circuiti che si danneggiano con urti o umidità, software che necessita aggiornamenti.

Applicazioni specialistiche: dove gli occhiali elettronici già eccellono

Mentre attendiamo che la tecnologia maturi per l'uso consumer quotidiano, gli occhiali a correzione elettronica stanno già trovando applicazioni in nicchie specializzate dove i vantaggi giustificano i costi e i limiti attuali.

Nel campo militare e aeronautico, visori con correzione adattiva sono integrati in caschi di piloti e sistemi heads-up display. La capacità di passare istantaneamente dalla lettura di strumenti ravvicinati all'identificazione di target lontani rappresenta un vantaggio tattico significativo.

In chirurgia, occhiali con ingrandimento variabile elettronicamente permettono ai chirurghi di passare dalla visione d'insieme del campo operatorio a ingrandimenti estremi per manovre di microchirurgia, senza dover cambiare dispositivo o interrompere la procedura.

Per persone con disabilità visive progressive, come degenerazione maculare o retinite pigmentosa, occhiali elettronici con elaborazione d'immagine in tempo reale possono migliorare il contrasto, ingrandire porzioni dell'immagine o evidenziare contorni, restituendo parzialmente l'autonomia visiva.

Nell'industria manifatturiera e nella manutenzione tecnica, realtà aumentata combinata con correzione adattiva permette ai lavoratori di vedere sia istruzioni e schemi sovrapposti ai macchinari che dettagli minuti di componenti senza rimuovere i dispositivi di protezione.

La convergenza con l'intelligenza artificiale

Il futuro degli occhiali intelligenti non risiede solo nella correzione ottica variabile, ma nella fusione con sistemi di intelligenza artificiale che trasformano completamente l'esperienza visiva.

Riconoscimento degli oggetti in tempo reale potrebbe fornire informazioni contestuali: guardando un edificio, gli occhiali potrebbero mostrare la sua storia; osservando un piatto in un ristorante, visualizzare ingredienti e valori nutrizionali; fissando una persona, ricordarne nome e ultimo incontro.

Traduzione visiva istantanea è già una realtà in prototipi avanzati: testi in lingue straniere vengono automaticamente tradotti e sovrapposti all'originale, mantenendo formato e posizione. Questa tecnologia potrebbe abbattere le barriere linguistiche globali.

Assistenza per ipovedenti potrebbe raggiungere livelli rivoluzionari: identificazione automatica di ostacoli, lettura ad alta voce di testi, riconoscimento facciale per identificare persone, analisi di scene complesse con descrizioni audio dettagliate.

La navigazione aumentata trasformerebbe il modo in cui ci muoviamo: frecce direzionali sovrapposte alla visione reale, informazioni su punti di interesse, avvisi di pericoli. Questa tecnologia è particolarmente promettente per soccorritori in ambienti pericolosi o astronauti in missioni extraterrestri.

Considerazioni etiche e sociali

L'evoluzione degli occhiali da semplici dispositivi correttivi a piattaforme computazionali avanzate solleva questioni etiche e sociali significative.

La privacy è la preoccupazione più immediata. Occhiali con fotocamere sempre attive e connessione a internet potrebbero registrare continuamente tutto ciò che l'utente vede, creando database di sorveglianza involontaria. Chi possiede questi dati? Come vengono utilizzati? Il fallimento di Google Glass fu in parte dovuto proprio al disagio sociale causato dall'impossibilità di sapere quando qualcuno stava registrando.

L'equità di accesso rappresenta un'altra sfida. Se occhiali elettronici avanzati diventano strumenti essenziali per lavoro, istruzione o vita quotidiana, le disparità economiche si trasformerebbero in disparità di capacità cognitive e percettive. Chi non può permettersi questa tecnologia sarebbe funzionalmente svantaggiato rispetto a chi la possiede.

La dipendenza tecnologica è un rischio concreto. Se deleghiamo a dispositivi esterni compiti come ricordare nomi, navigare spazi, o accedere a informazioni, potremmo atrofizzare capacità cognitive naturali. Questo fenomeno è già osservato con smartphone; occhiali intelligenti, essendo sempre presenti e richiedendo meno interazione attiva, potrebbero accentuarlo.

La sicurezza cibernetica diventa critica quando un dispositivo ha accesso costante alla nostra visione e potenzialmente controlla cosa vediamo. Attacchi hacker potrebbero alterare percezioni, iniettare informazioni false, o causare disorientamento e pericolo fisico.

Dagli antichi vetri dei monaci veneziani agli occhiali che si adattano istantaneamente alle nostre esigenze, guidati da intelligenza artificiale, la storia degli occhiali è una storia di ingegno umano che supera limiti biologici. La correzione elettronica della vista non è più fantascienza ma una realtà emergente che promette di trasformare non solo come vediamo, ma come interagiamo con il mondo. Le sfide tecniche, economiche ed etiche sono significative, ma il progresso sembra inesorabile verso un futuro in cui la distinzione tra visione naturale e aumentata diventerà sempre più sfumata.

Di Alex (pubblicato @ 13:00:00 in Green Tech & Auto, letto 237 volte)

Il sorpasso storico delle energie pulite. A sinistra cosa vorrebbe Trump e quelli che lo votano.

È successo davvero. Secondo l'IEA, quest'anno segna il sorpasso storico: le energie rinnovabili sono ufficialmente la prima fonte di elettricità globale. Un traguardo che sembrava impossibile solo un decennio fa e che ora è realtà. LEGGI TUTTO L'ARTICOLO

La fine dell'era fossile

Non è solo una questione di pannelli solari ovunque. La vera chiave è stata la tecnologia di stoccaggio. Le nuove batterie LFP e ferro-aria permettono di conservare l'energia del sole e del vento per giorni, stabilizzando la rete anche quando è notte o non c'è brezza. Il carbone è diventato semplicemente antieconomico.

Il Ruolo dell'AI

Paradossalmente, l'intelligenza artificiale, che consuma tanta energia, è anche quella che ne ottimizza la distribuzione. Le nuove Smart Grid bilanciano i flussi in millisecondi, rendendo la rete elettrica un organismo vivente ed efficiente. Il futuro è luminoso, ed è pulito.

Abbiamo voltato pagina nella storia dell'energia umana.

Di Alex (pubblicato @ 13:00:00 in Green Tech & Auto, letto 268 volte)

Quando l'IoT incontra la resilienza urbana

Le metropoli non sono più giungle di asfalto passive. Grazie all'IoT e all'IA, le nostre città "sentono" l'arrivo di ondate di calore o alluvioni, adattandosi in tempo reale per proteggere i cittadini più fragili e le infrastrutture. LEGGI TUTTO L'ARTICOLO

Un Organismo Reattivo

Immaginate cassonetti che chiamano i camion solo quando sono pieni, riducendo traffico e smog. O sistemi idrici che svuotano preventivamente i bacini se l'IA prevede un nubifragio. Le Smart City del 2026 usano i dati per salvare vite e risorse.

Proteggere i più Deboli

Durante le ondate di calore, la città sa dove intervenire, gestendo l'energia per garantire aria condizionata negli ospedali e nelle case di riposo. La tecnologia non serve solo a renderci più veloci, ma a renderci più resilienti di fronte a un clima che cambia.

La città del futuro non è solo smart, è premurosa.

Di Alex (pubblicato @ 11:00:00 in Software & Sicurezza, letto 280 volte)

Il gemello digitale della Terra per le previsioni climatiche

Immaginate di poter prevedere un uragano mesi prima che si formi o di testare una diga in un mondo virtuale identico al nostro. Non è fantascienza, è la nuova frontiera dei "World Models" che simulano la fisica reale per salvare l'ambiente. LEGGI TUTTO L'ARTICOLO

Dalla Reazione alla Prevenzione

Il 2026 segna la fine dell'era in cui rincorrevamo i disastri. Grazie a piattaforme come Nvidia Cosmos, l'Intelligenza Artificiale non si limita più a leggere numeri, ma "comprende" le leggi della fisica, dalla fluidodinamica all'atmosfera. Questo ci permette di creare simulatori climatici accuratissimi.

Simulare per non Sbagliare

Prima di costruire una turbina eolica o una barriera contro le inondazioni, oggi possiamo testarle in milioni di scenari virtuali accelerati. È una rivoluzione silenziosa che trasforma la gestione del territorio da scommessa a scienza esatta, riducendo gli sprechi e massimizzando la sicurezza per tutti noi.

La tecnologia è diventata il sistema nervoso del nostro pianeta.

Di Alex (pubblicato @ 09:00:00 in Capolavori tecnologici, letto 281 volte)

Vista aerea dell'iconica Palm Jumeirah a Dubai, con la sua forma a palma e il frangiflutti a mezzaluna.

A Dubai, l'ambizione di creare nuova terra dal mare ha portato alla realizzazione di Palm Jumeirah, un arcipelago artificiale iconico. Questo progetto ha richiesto tecniche innovative per modellare la sabbia e stabilizzare il terreno, ma ha anche sollevato importanti questioni ambientali e dimostrato i limiti dell'ingegneria speculativa con il progetto "The World". LEGGI TUTTO L'ARTICOLO

Costruire con la sabbia: "Rainbowing" e vibro-compattazione

Palm Jumeirah è stata creata spruzzando milioni di metri cubi di sabbia con navi draganti, una tecnica nota come "rainbowing". Per rendere la sabbia stabile e edificabile, è stata utilizzata la vibro-compattazione: sonde vibranti hanno densificato il terreno in oltre 200.000 punti, prevenendo la liquefazione in caso di terremoti.

Sfide ambientali e soluzioni

Il frangiflutti iniziale causava il ristagno dell'acqua tra le fronde. Gli ingegneri hanno dovuto aprire due varchi per permettere il ricambio naturale delle maree ed evitare un disastro ecologico. Tuttavia, l'opera ha alterato le correnti costiere, causando erosione e richiedendo un costante ripascimento delle spiagge. Dati satellitari suggeriscono anche un lento assestamento dell'isola.

Il destino di "The World"

Mentre Palm Jumeirah è una realtà abitata, il vicino progetto "The World", un arcipelago a forma di mappa terrestre, ha incontrato maggiori difficoltà. La crisi finanziaria e la mancanza di collegamenti hanno lasciato molte isole disabitate e soggette a erosione, un monito sui rischi di progetti ingegneristici così vasti e speculativi.

Di Alex (pubblicato @ 07:00:00 in Donne scienziate, letto 284 volte)

Marietta Blau nel suo laboratorio di Vienna negli anni '30 esamina al microscopio lastre fotografiche con tracce di particelle cosmiche

Marietta Blau inventò il metodo delle emulsioni nucleari fotografiche che rese visibili le particelle subatomiche. Scoprì le stelle di disintegrazione nel 1937, ma dovette fuggire dal nazismo. Cecil Powell vinse il Nobel nel 1950 con le sue tecniche, senza mai citarla. Morì indigente nel 1970. LEGGI TUTTO L'ARTICOLO

Una vocazione scientifica contro ogni ostacolo

Marietta Blau nacque il 29 aprile 1894 a Vienna, capitale dell'Impero austro-ungarico, in una famiglia ebraica della borghesia medio-alta. Suo padre Mayer Markus Blau era un avvocato affermato ed editore musicale, figura rispettata nella comunità intellettuale viennese, mentre la madre Florentine Goldzweig proveniva anch'essa da una famiglia benestante. Marietta era la terza di quattro figli e l'unica femmina, una circostanza che in epoca vittoriana avrebbe normalmente significato un'educazione orientata esclusivamente alle arti domestiche. Tuttavia i Blau credevano nell'istruzione femminile e iscrissero Marietta al liceo femminile di Rahlgasse, il primo liceo per ragazze fondato in Austria dal Verein für Erweiterte Frauenbildung, un'associazione per i diritti educativi delle donne.

Nel luglio 1914 Marietta conseguì la maturità con lode, risultato eccezionale per una ragazza in un'epoca in cui le università prussiane avevano iniziato ad ammettere studentesse solo dal 1908 e la resistenza culturale contro la presenza femminile nelle facoltà scientifiche rimaneva fortissima. Nell'autunno dello stesso anno, mentre l'Europa sprofondava nella Prima Guerra Mondiale, Marietta si iscrisse alla facoltà di filosofia dell'Università di Vienna, dove la fisica era insegnata come disciplina filosofica secondo la tradizione austro-tedesca. Studiò fisica come materia principale e matematica come secondaria, navigando in un ambiente accademico dominato da uomini che consideravano le studentesse intruse in un territorio maschile. Nel 1919 si laureò discutendo una tesi sull'assorbimento dei raggi gamma, dimostrando sin da subito interesse per i fenomeni radioattivi che avrebbero segnato tutta la sua carriera.

Il Radium Institute e l'inizio della ricerca

Durante l'ultimo anno di studi Marietta iniziò un periodo di apprendistato presso l'Istituto per la Ricerca sul Radio dell'Accademia delle Scienze austriaca, uno dei tre più prestigiosi centri di ricerca sulla radioattività dell'epoca insieme al laboratorio di Marie Curie a Parigi e all'Istituto Kaiser Wilhelm di Berlino. Il direttore Stefan Meyer, fisico illuminato, mostrava un'apertura insolita verso le collaboratrici donne, probabilmente anche perché molti ricercatori dell'Istituto non venivano pagati. Si creò così in Europa negli anni Venti un collegio invisibile di donne impegnate nello studio della radioattività e della fisica nucleare che mantennero contatti professionali e personali per tutta la vita, tra cui Lise Meitner, Harriet Brooks e la stessa Marietta Blau.

Dopo la laurea, tra il 1920 e il 1921, Marietta lasciò Vienna e lavorò a Berlino presso un produttore di tubi radiogeni, acquisendo preziose competenze tecniche sulla produzione industriale di apparecchiature a raggi X. Nel 1921 ottenne un posto come assistente all'Istituto di Fisica Medica dell'Università di Francoforte sul Meno, dove insegnava ai futuri medici radiologi le basi teoriche e pratiche della radiologia, disciplina nascente che prometteva di rivoluzionare la diagnostica medica. Pubblicò diversi articoli sui raggi X e sulle loro applicazioni mediche. Ma il suo desiderio era tornare alla ricerca pura, così nel 1923 accettò di lavorare come ricercatrice non retribuita presso il Radium Institute di Vienna, dove sarebbe rimasta per i successivi quattordici anni, il periodo più produttivo della sua carriera scientifica.

L'invenzione delle emulsioni nucleari

Negli anni Venti la fisica nucleare affrontava un problema metodologico fondamentale: come rivelare e studiare le particelle subatomiche che erano invisibili a occhio nudo e ai microscopi ottici. Le particelle emesse nei decadimenti radioattivi o prodotte nelle interazioni nucleari venivano rivelate utilizzando materiali che producevano scintillazioni luminose al passaggio di particelle cariche. I ricercatori dovevano osservare e contare manualmente questi flash di luce in camere oscure, procedura estenuante soggetta a errori, fatigue visiva e forte dipendenza dalle capacità individuali dell'operatore. Nel 1925 il fisico svedese Hans Petterson, trasferitosi temporaneamente a Vienna per studiare la radioattività del fondo sottomarino, chiese a Marietta di investigare la possibilità di utilizzare emulsioni fotografiche per tracciare le particelle.

La tecnica era già stata adottata sporadicamente per rivelare particelle alfa, i nuclei di elio formati da due protoni e due neutroni emessi da alcuni isotopi radioattivi, ma nessuno l'aveva sviluppata sistematicamente. Marietta intuì immediatamente il potenziale rivoluzionario: quando una particella carica attraversa un'emulsione fotografica, ionizza gli atomi di bromuro d'argento lungo la sua traiettoria lasciando una traccia permanente che può essere sviluppata chimicamente e analizzata al microscopio. Nel 1925 Blau dimostrò per la prima volta che era possibile rivelare protoni di bassa energia usando questa metodologia. Tra il 1925 e il 1932 perfezionò pazientemente la tecnica, sperimentando centinaia di formule chimiche diverse, collaborando con produttori fotografici come Ilford e Kodak per sviluppare emulsioni più sensibili, testando vari processi di sviluppo per ottenere la massima chiarezza delle tracce.

Vedere l'invisibile: la rivoluzione metodologica

Il lavoro di Marietta Blau tra il 1925 e il 1937 costituì un'autentica rivoluzione nella fisica sperimentale. Produsse oltre diecimila tracce controllate usando fasci di protoni di energia nota, misurò accuratamente la relazione tra lunghezza della traccia ed energia della particella, determinò come distinguere protoni da particelle alfa analizzando la densità e la forma della scia. Nel 1927 pubblicò un report fondamentale che rendeva solido e riproducibile il metodo per misurare l'energia delle particelle dall'analisi delle emulsioni, trasformando questa tecnica da curiosità di laboratorio a strumento quantitativo affidabile. Le sue emulsioni nucleari permettevano finalmente di registrare eventi rari senza la presenza continua dell'operatore, di conservare prove permanenti per verifiche successive, e di analizzare dettagli microscopici invisibili con altre tecniche.

Nel 1932 Marietta accolse come studente di dottorato Hertha Wambacher, giovane fisica che divenne sua assistente e collaboratrice. Insieme determinarono le energie dei neutroni, particelle elettricamente neutre scoperte da James Chadwick proprio nel 1932, misurando le tracce dei protoni di rinculo in emulsioni speciali contenenti sostanze grasse ricche di idrogeno. Quando un neutrone colpisce un nucleo di idrogeno, trasferisce la sua energia cinetica al protone che viene espulso lasciando una traccia visibile nell'emulsione. Analizzando statisticamente migliaia di tracce di protoni di rinculo, Marietta e Hertha potevano determinare lo spettro energetico dei neutroni incidenti. Questa capacità di rivelare particelle neutre indirettamente attraverso le loro interazioni rappresentò un ulteriore salto qualitativo nella potenza della metodologia.

Le stelle di disintegrazione e la gloria breve

Nel 1936 Marietta e Hertha decisero di applicare le emulsioni allo studio dei raggi cosmici, le misteriose particelle ad altissima energia provenienti dallo spazio scoperte da Victor Hess nel 1912. Poiché i raggi cosmici vengono dispersi e attenuati dall'atmosfera terrestre, era necessario esporre le lastre fotografiche ad alta quota. Marietta e Hertha ottennero il permesso di utilizzare l'osservatorio Hafelekar situato a 2300 metri di altitudine sul monte Hafelekarspitze vicino a Innsbruck, struttura costruita proprio da Hess per i suoi studi pionieristici. Per cinque mesi, tra il 1936 e il 1937, pile di lastre fotografiche appositamente progettate rimasero esposte alla radiazione cosmica in condizioni di temperatura e umidità controllate.

Quando Marietta e Hertha svilupparono le lastre nel laboratorio viennese, scoprirono eventi straordinari che nessuno aveva mai osservato prima: alcuni punti nell'emulsione mostravano numerose tracce che si irradiavano da un centro comune, come minuscoli fuochi d'artificio o stelle. Marietta le chiamò stelle di disintegrazione. L'interpretazione fisica era chiara: un raggio cosmico primario ad altissima energia aveva colpito un nucleo pesante di argento o bromo nell'emulsione, frantumandolo in molti frammenti più piccoli che si propagavano in tutte le direzioni. Era la prima evidenza sperimentale diretta che particelle sufficientemente energetiche potevano disintegrare nuclei atomici pesanti producendo cascate di particelle secondarie. La scoperta confermava brillantemente le previsioni teoriche di Werner Heisenberg sulla natura delle interazioni nucleari ad alta energia.

Il Nobel mancato e la fuga dal nazismo

Nel febbraio 1937 Marietta e Hertha pubblicarono la scoperta delle stelle di disintegrazione su Nature, la rivista scientifica più prestigiosa al mondo. L'articolo suscitò immediato scalpore nella comunità dei fisici nucleari e dei raggi cosmici: finalmente era possibile studiare eventi nucleari rari ad altissima energia con una tecnica relativamente semplice ed economica. Per questo lavoro le due ricercatrici ricevettero il prestigioso Premio Lieben dell'Accademia Austriaca delle Scienze nel 1937, massimo riconoscimento scientifico nazionale. Sembrava l'inizio di una carriera trionfale che avrebbe portato Marietta al Premio Nobel, come suggerito da Erwin Schrödinger che la candidò insieme a Wambacher per il Nobel 1950. Ma la Storia aveva altri piani.

Nel marzo 1938 la Germania nazista annesse l'Austria nel cosiddetto Anschluss. Improvvisamente Marietta Blau, ebrea, si trovò cittadina del Terzo Reich soggetta alle Leggi di Norimberga che escludevano gli ebrei da qualsiasi posizione accademica o professionale. Poche settimane prima dell'annessione, Albert Einstein scrisse una lettera di raccomandazione per Marietta indirizzata a colleghi messicani: "Mi prendo la libertà di portare alla vostra attenzione un caso che mi sta a cuore: la dottoressa Marietta Blau, dal talento eccezionale ed esperta nel campo della radioattività. Per ragioni politiche ben note sarà costretta a lasciare il suo paese prima o poi. Se riusciste a portarla a Città del Messico fareste un ottimo servizio allo sviluppo della scienza". Marietta fuggì precipitosamente verso Oslo su invito della chimica norvegese Ellen Gleditsch che aveva compreso la gravità della situazione.

Il tradimento di Wambacher e l'esilio messicano

Durante la breve assenza di Marietta da Vienna nei mesi precedenti l'Anschluss, Hertha Wambacher aveva iniziato a collaborare con Georg Stetter, fisico attivo nazista membro del gruppo di Petterson. Wambacher si iscrisse al Partito Nazionalsocialista e si legò sentimentalmente a Stetter. Dopo la fuga di Marietta, Wambacher non solo non la difese pubblicamente ma smise completamente di citarla nei suoi lavori, disconoscendo la propria insegnante ebrea per conformarsi all'ideologia nazista che cancellava sistematicamente i contributi scientifici degli ebrei. Questa amicizia spezzata aggiunse una ferita personale al trauma dell'esilio forzato che Marietta stava subendo.

Da Oslo Marietta si trasferì a Città del Messico nel 1940 dove accettò un posto presso la Escuela Superior de Ingenieria Mecanica y Electrica. Fu l'unica donna in tutto l'istituto e lavorò con grande frustrazione e delusione per le scarse risorse e le limitate opportunità di ricerca offerte dall'università messicana. Organizzò escursioni su montagne e vulcani come il Popocatepetl dotando gli studenti di lastre fotografiche per registrare radiazioni cosmiche, condusse ricerche sulla radioattività della crosta terrestre legata all'attività sismica e vulcanica del Messico, studiò gli effetti delle radiazioni solari sulla salute. Ma non poteva accedere a laboratori attrezzati, acceleratori di particelle o collaborazioni internazionali. Erano anni di isolamento scientifico mentre in Europa e negli Stati Uniti la fisica nucleare avanzava rapidamente verso applicazioni militari con il Progetto Manhattan.

Gli Stati Uniti e il Nobel rubato

Nel maggio 1944 Marietta lasciò il Messico trasferendosi a New York dove viveva suo fratello Ludwig. Iniziò lavorando per la Canadian Radium and Uranium Corporation nell'industria privata, poi nel 1948 ottenne una posizione come ricercatrice alla Columbia University, finanziata dalla Atomic Energy Commission nel contesto della ricerca nucleare postbellica. Era l'unica donna tra i ricercatori e aveva l'incarico di migliorare l'applicazione delle emulsioni nucleari per lo studio delle particelle ad alta energia prodotte dai nuovi acceleratori. Nel 1950 fu trasferita al Brookhaven National Laboratory a Long Island dove era stato costruito il Cosmotrone, acceleratore di particelle all'avanguardia, per applicare il metodo fotografico agli esperimenti con fasci accelerati.

Nel 1950 l'Accademia Svedese delle Scienze assegnò il Premio Nobel per la Fisica a Cecil Frank Powell con la seguente motivazione: "per il suo sviluppo del metodo fotografico di studio dei processi nucleari e le sue scoperte riguardanti i mesoni fatta con questo metodo". Powell aveva effettivamente scoperto il pione, particella prevista teoricamente da Hideki Yukawa, analizzando emulsioni esposte ai raggi cosmici nel 1947. Ma Powell, come tutti i ricercatori del settore, aveva iniziato a utilizzare le emulsioni fotografiche solo nel 1938 dopo che furono riconosciuti i vantaggi del metodo sviluppato da Marietta Blau. La scoperta del pione di Powell si basava interamente sui lavori pionieristici di Marietta. Durante il discorso ufficiale di accettazione del Nobel, Powell non citò nemmeno il nome di Marietta Blau o riconobbe in alcun modo il suo contributo fondamentale.

Le nomination ignorate e il ritorno a Vienna

Erwin Schrödinger, Premio Nobel per la Fisica 1933 e uno dei padri della meccanica quantistica, candidò Marietta Blau al Premio Nobel per la Fisica nel 1950 insieme a Hertha Wambacher per essere stata la prima a sviluppare la tecnica fotografica delle emulsioni nucleari e per la scoperta delle stelle di disintegrazione. La candidatura fu ignorata a favore di Powell. Schrödinger non si arrese e la candidò nuovamente nel 1956 e nel 1957, questa volta per il Premio Nobel per la Chimica. Anche Hans Thirring, fisico austriaco, la candidò nel 1955. Nessuna di queste nomination ebbe successo. La comunità scientifica internazionale non dimenticava il suo nome, ma il comitato Nobel sì.

Nel 1955 Marietta divenne professore associato presso l'Università di Miami in Florida grazie a una borsa di studio dell'United States Air Force. Allestì un laboratorio attrezzato dove proseguì le ricerche sulle emulsioni nucleari, ma anni di esposizione a sostanze radioattive iniziavano a minare gravemente la sua salute. Soffriva di rigidità articolare alle mani che rendeva difficile il lavoro di laboratorio, sviluppò cataratta agli occhi richiedendo un intervento chirurgico urgente. Non avendo accumulato contributi previdenziali negli Stati Uniti, decise di tornare a Vienna nel 1960 dove i costi sanitari erano inferiori grazie al sistema pubblico austriaco. Suo desiderio era rientrare negli Stati Uniti dopo l'operazione, ma le condizioni di salute non glielo permisero più.

Gli ultimi anni e la morte indigente

A Vienna Marietta riprese a lavorare, nuovamente a titolo gratuito, presso l'Istituto per la Ricerca sulla Radioattività dove era iniziata la sua carriera quarant'anni prima. Guidò un gruppo di lavoro che analizzava le riprese fotografiche delle tracce degli esperimenti condotti al CERN, il neonato laboratorio europeo di fisica delle particelle fondato nel 1954 a Ginevra. Fu anche relatrice di una tesi di dottorato sull'argomento, dimostrando che la sua competenza scientifica rimaneva intatta nonostante l'età e la malattia. Nel 1962 le venne conferito il Premio Erwin Schrödinger, massimo riconoscimento scientifico austriaco, tardivo omaggio che non compensava decenni di marginalizzazione e mancato riconoscimento internazionale. Tuttavia l'Accademia Austriaca delle Scienze rifiutò la sua ammissione come membro, perpetuando fino all'ultimo l'esclusione di questa pioniera.

Marietta Blau morì il 27 gennaio 1970 a Vienna a causa di un tumore, probabilmente conseguenza dell'esposizione prolungata alle radiazioni durante decenni di ricerche sulla radioattività. Morì indigente, senza risparmi, dipendendo dalla minima pensione sociale austriaca. I necrologi nei principali giornali scientifici furono brevi e sbrigativi, sottolineando la scoperta delle stelle di disintegrazione ma omettendo la questione del Nobel negato a favore di Powell, perpetuando l'oblio che aveva accompagnato tutta la sua carriera. Ruth Lewin Sime, storica della scienza che ha studiato approfonditamente la sua biografia, scrisse: "Marietta Blau è la figura più tragica nella storia dei raggi cosmici. La sua vita e il suo lavoro furono caratterizzati da avversità e contraccolpi, eppure i suoi risultati eccellono quelli di molti altri che vennero premiati con il Nobel nel contesto dei raggi cosmici".

L'eredità scientifica delle emulsioni nucleari

La tecnica delle emulsioni nucleari fotografiche sviluppata da Marietta Blau divenne lo strumento standard della fisica delle particelle per oltre trent'anni. Permise la scoperta non solo del pione da parte di Powell nel 1947, ma anche del kaone nel 1947, dell'iperone sigma nel 1953 e di numerose altre particelle esotiche che popolavano il cosiddetto zoo delle particelle prima dell'avvento del modello a quark negli anni Sessanta. Le emulsioni erano economiche, non richiedevano alimentazione elettrica, potevano essere esposte per lunghi periodi in luoghi remoti come cime montane o stratosfera tramite palloni aerostatici. La loro risoluzione spaziale submicrometrica permetteva di ricostruire dettagli finissimi delle interazioni nucleari impossibili da osservare con altri rivelatori dell'epoca.

Negli anni Cinquanta e Sessanta migliaia di fisici in tutto il mondo passavano ore al microscopio analizzando emulsioni esposte ai raggi cosmici o agli acceleratori, un lavoro meticoloso e paziente che richiedeva competenze sviluppate proprio da Marietta nei suoi anni viennesi. Le emulsioni nucleari furono utilizzate nell'esperimento Opera ai Laboratori Nazionali del Gran Sasso tra il 2008 e il 2018 per rivelare le oscillazioni dei neutrini, fenomeno che valse il Premio Nobel per la Fisica 2015 a Takaaki Kajita e Arthur McDonald. Ancora oggi le emulsioni vengono impiegate in applicazioni di frontiera come la tomografia muonica per studiare l'interno delle piramidi egizie o dei vulcani attivi, sfruttando la penetrazione dei muoni cosmici attraverso grandi masse di materia.

Marietta Blau inventò uno strumento che permise di vedere l'invisibile, aprendo una finestra sul mondo subatomico che cambiò la fisica del XX secolo. Dovette fuggire dal nazismo perdendo collaboratori, riconoscimenti e la possibilità di assistere al trionfo delle sue tecniche. Cecil Powell vinse il Nobel usando i suoi metodi senza mai citarla. Morì sola e povera a Vienna, la città dove aveva iniziato la sua carriera brillante. La sua storia ci ricorda che il progresso scientifico non è lineare né giusto, e che troppe menti geniali sono state sacrificate alle ideologie totalitarie e alle discriminazioni di genere che hanno impoverito l'umanità intera.

Fotografie del 09/01/2026

Nessuna fotografia trovata.

Think different!

Think different!

Microsmeta Podcast

Microsmeta Podcast Feed Atom 0.3

Feed Atom 0.3

(p)Link

(p)Link Commenti

Commenti Storico

Storico Stampa

Stampa