\\ Home Page : Pubblicazioni

Di seguito gli articoli e le fotografie pubblicati nella giornata richiesta.

Articoli del 06/02/2026

Fotogramma del film Woman in the Moon con il razzo a più stadi in fase di lancio

Diretto da Fritz Lang, Woman in the Moon è considerato uno dei primi film a descrivere accuratamente la meccanica del viaggio spaziale, molto prima che la corsa allo spazio diventasse una realtà politica. Il film ha introdotto il conto alla rovescia prima del lancio. LEGGI TUTTO L'ARTICOLO

La consulenza scientifica di Hermann Oberth

Woman in the Moon, in tedesco Frau im Mond, ha introdotto al grande pubblico concetti che sarebbero diventati standard decenni dopo, come il razzo a più stadi e il conto alla rovescia prima del lancio. La consulenza scientifica fu fornita da Hermann Oberth, uno dei padri della missilistica moderna, garantendo che la rappresentazione fisica del lancio e della navigazione nello spazio fosse basata su principi aerospaziali reali.

La capacità del film di anticipare la tecnologia di trent'anni rimane un esempio precoce di come il cinema possa fungere da laboratorio per la visualizzazione scientifica. Il film utilizzava modellini fisici per simulare la gravità zero e le manovre orbitali, creando un precedente metodologico per il genere fantascientifico.

Innovazioni tecniche e narrative

Fritz Lang, già famoso per Metropolis del millenovecento ventisette, portò nel film Woman in the Moon la stessa attenzione maniacale ai dettagli tecnici. Il regista tedesco collaborò strettamente con Oberth per garantire che ogni aspetto del viaggio lunare fosse plausibile secondo le conoscenze scientifiche dell'epoca.

Il film presenta una sequenza di lancio dettagliata che mostra il razzo a più stadi, un concetto che sarebbe diventato realtà solo con i missili V-2 durante la Seconda Guerra Mondiale e poi con i razzi spaziali della NASA. La rappresentazione della separazione degli stadi, della traiettoria parabolica e dell'assenza di gravità nello spazio dimostrava una comprensione sofisticata della fisica orbitale.

Il conto alla rovescia: un'innovazione cinematografica

Una delle eredità più durature del film è l'introduzione del conto alla rovescia prima del lancio. Questa sequenza, creata per aumentare la tensione drammatica, divenne così iconica che fu adottata dai programmi spaziali reali. Oggi il countdown è una caratteristica standard di ogni lancio spaziale, nato dalla fantasia cinematografica di Lang.

L'eredità scientifica e culturale

Woman in the Moon rappresenta un punto di svolta nella storia del cinema di fantascienza. Mentre film precedenti come Le Voyage dans la Lune di Méliès del millenovecentodue erano puramente fantastici, Lang e Oberth dimostrarono che la scienza poteva essere integrata nella narrazione cinematografica senza sacrificare lo spettacolo.

Hermann Oberth stesso continuò a lavorare sulla missilistica, contribuendo allo sviluppo dei razzi V-2 tedeschi e successivamente al programma spaziale americano. La sua consulenza per il film dimostrava come la collaborazione tra scienziati e artisti potesse produrre opere che educavano il pubblico e anticipavano il futuro.

Il film di Lang rimane un esempio straordinario di rigore scientifico nel cinema. Utilizzando modellini fisici, consulenza esperta e tecniche cinematografiche innovative, Woman in the Moon stabilì uno standard per la fantascienza realistica che influenza ancora oggi registi come Christopher Nolan e Ridley Scott. La visione di un viaggio lunare tecnicamente plausibile ispirò generazioni di scienziati e ingegneri aerospaziali.

Di Alex (pubblicato @ 15:00:00 in Automotive, letto 69 volte)

Convergenza tra intelligenza artificiale e applicazioni fisiche nel mondo reale

Il duemilaventisei segna il punto di convergenza tra maturazione delle architetture di intelligenza artificiale e applicazione fisica nel mondo reale. La transizione verso consolidamento industriale e stabilità operativa ridefinisce i paradigmi della computazione, medicina rigenerativa, esplorazione spaziale e sostenibilità dei materiali. LEGGI TUTTO L'ARTICOLO

Il panorama tecnologico del 2026: dalla sperimentazione al consolidamento

Se il biennio precedente è stato caratterizzato da una frenesia esplorativa nella sperimentazione di modelli di intelligenza artificiale generativa, il panorama attuale riflette una maturazione strategica. Le organizzazioni stanno transitando dalla fase di prototipazione a quella di integrazione operativa, dove l'efficacia si misura non più in termini di capacità teorica, ma di impatto misurabile sui flussi di lavoro aziendali e sui processi produttivi.

La presente analisi delinea le principali traiettorie di sviluppo che stanno ridefinendo i paradigmi tecnologici contemporanei. Ogni ambito è esaminato non solo attraverso il dato tecnico, ma contestualizzando il meccanismo di funzionamento e le prospettive di integrazione nel tessuto socio-economico globale. L'obiettivo è fornire una mappatura sistematica delle frontiere dove scienza, ingegneria e applicazione commerciale convergono.

Architetture computazionali e intelligenza artificiale agentica

Il calcolo non è più un'entità statica, ma un ecosistema dinamico dove la distinzione tra software tradizionale e intelligenza si sta rapidamente dissolvendo. Le organizzazioni stanno adottando piattaforme che non solo rispondono a query specifiche, ma agiscono autonomamente su flussi di lavoro complessi, orchestrando risorse e prendendo decisioni in contesti multi-dominio.

Le piattaforme di sviluppo native per l'intelligenza artificiale rappresentano una rottura radicale con i metodi tradizionali di ingegneria del software. Invece di scrivere linee di codice per definire logiche rigide e predeterminate, gli sviluppatori utilizzano l'intelligenza artificiale generativa per costruire micro-applicazioni scalabili in tempi drasticamente ridotti. Questo cambiamento sposta la decisione aziendale dal tradizionale dilemma "comprare software pronto" o "costruirlo da zero" verso un modello di innovazione interna rapida.

Democratizzazione dello sviluppo di alto livello

Nel duemilaventisei, queste piattaforme hanno raggiunto lo stato di "enterprise-ready", integrando governance, sicurezza e conformità normativa direttamente nel ciclo di vita del software. L'implicazione profonda è la democratizzazione dello sviluppo applicativo ad alto livello, permettendo anche a figure non prettamente tecniche di orchestrare soluzioni digitali complesse attraverso il linguaggio naturale.

Piccoli team possono ora agire come motori ad alta velocità di innovazione, bypassando le tradizionali gerarchie di sviluppo che richiedevano mesi di pianificazione, codifica e test. La velocità di iterazione permette sperimentazioni rapide e adattamenti in tempo reale alle esigenze del mercato, riducendo drasticamente il time-to-market per nuovi servizi digitali.

Medicina rigenerativa e biotecnologie avanzate

La convergenza tra biologia sintetica, intelligenza artificiale applicata alla scoperta di farmaci e tecnologie di editing genetico sta aprendo frontiere terapeutiche precedentemente confinate alla fantascienza. Gli approcci di medicina personalizzata, basati sul sequenziamento genomico completo del paziente, stanno transitando da applicazioni sperimentali a protocolli clinici standardizzati.

Le terapie cellulari CAR-T, che riprogrammano le cellule immunitarie del paziente per riconoscere e distruggere cellule tumorali, stanno estendendo la loro applicabilità oltre i tumori ematologici verso neoplasie solide. Parallelamente, l'ingegneria tissutale sta producendo organoidi sempre più complessi, utilizzati sia per la ricerca farmacologica che come potenziali sostituti trapiantabili di tessuti danneggiati.

Esplorazione spaziale e sostenibilità orbitale

L'economia spaziale sta vivendo una trasformazione radicale, guidata dalla riduzione dei costi di lancio e dalla commercializzazione delle infrastrutture orbitali. Le costellazioni satellitari per telecomunicazioni globali, iniziate con progetti come Starlink, stanno proliferando, sollevando questioni critiche sulla sostenibilità dell'ambiente orbitale e sulla gestione dei detriti spaziali.

Parallelamente, le missioni di esplorazione lunare stanno transitando da progetti simbolici a programmi di insediamento permanente, con l'obiettivo di stabilire basi di supporto per l'estrazione di risorse e come piattaforme di lancio verso Marte. Le tecnologie di produzione in situ di propellenti e materiali costruttivi utilizzando risorse lunari rappresentano un requisito fondamentale per la sostenibilità economica di queste iniziative.

Sostenibilità dei materiali e economia circolare

La crisi climatica sta accelerando l'innovazione nei materiali sostenibili e nei processi di riciclo avanzato. Le tecnologie di cattura e sequestro del carbonio stanno evolvendo verso applicazioni industriali scalabili, mentre nuovi materiali bio-based stanno sostituendo plastiche derivate da petrolio in settori chiave come il packaging e l'edilizia.

L'intelligenza artificiale sta rivoluzionando la scoperta di nuovi materiali attraverso simulazioni molecolari che predicono proprietà fisiche e chimiche senza necessità di sintesi sperimentale, riducendo drasticamente i tempi di sviluppo. Parallelamente, i sistemi di tracciabilità basati su blockchain stanno abilitando economie circolari verificabili, dove ogni componente può essere tracciato attraverso l'intero ciclo di vita, facilitando recupero e riciclo efficiente.

Il duemilaventisei rappresenta un anno di consolidamento strategico, dove le promesse tecnologiche degli anni precedenti stanno cristallizzandosi in applicazioni concrete e scalabili. La convergenza tra intelligenza artificiale, biotecnologie, esplorazione spaziale e sostenibilità dei materiali sta ridefinendo non solo i paradigmi industriali, ma anche le aspettative sulla capacità umana di affrontare sfide globali complesse. Il successo di questa transizione dipenderà dalla capacità di integrare innovazione tecnologica con governance responsabile e considerazioni etiche rigorose.

Di Alex (pubblicato @ 14:00:00 in Capolavori dell'Antichità, letto 63 volte)

Vista delle possenti mura ciclopiche di Tirinto con massi calcarei di diverse tonnellate

Le mura sono spesse fino a otto-dieci metri e costruite con massi calcarei di diverse tonnellate. Includono gallerie voltate a corbellatura all'interno dello spessore murario, usate come magazzini difensivi. La leggenda voleva che fossero costruite dai Ciclopi per il re Preto. LEGGI TUTTO L'ARTICOLO

La cittadella fortificata dell'Argolide

Tirinto fu un'antica città dell'Argolide, in Grecia, situata nel settore sud-orientale della piana di Argo. Fa parte dell'elenco dei patrimoni dell'umanità dell'UNESCO. Della città restano soltanto alcuni resti archeologici: le mura e le rovine del Palazzo reale, scoperto da Heinrich Schliemann e Christos Tsountas nel milleottocentoottantaquattro-milleottocentoottantacinque.

L'apogeo della civiltà micenea avvenne nel periodo terzo, intorno al millequattrocento-millecentoventi avanti Cristo, ed era caratterizzato dalla costruzione di potenti cittadelle e vasti palazzi. Le mura ciclopiche della fortezza di Tirinto, il cui spessore è in media di sei metri, in qualche punto raggiungono ancora i dieci metri di altezza.

La tecnica costruttiva megalitica

Le mura ciclopiche vengono utilizzate per recingere le cittadelle di Micene, di Argo, di Tirinto e per rafforzare artificialmente, con sbarramenti di pietra, siti già naturalmente protetti. Si presentano normalmente sottoforma di cortine murarie continue attraversate unicamente da porte sormontate da grandiosi monoliti disposti a formare rudimentali architravi.

La muratura ciclopica è un tipo di pietra trovata nell'architettura micenea, costruita con massi di calcare, approssimativamente montati insieme con una distanza minima tra le pietre adiacenti e con malta di argilla o nessun uso di malta. I massi in genere sembrano non lavorati, ma alcuni potrebbero essere stati lavorati approssimativamente con un martello e gli spazi tra i massi riempiti con piccole pietre.

Le gallerie voltate e i magazzini difensivi

A sud-ovest e a sud, all'interno delle mura che qui hanno forma di bastione, sono sistemate alcune casematte accessibili mediante scale e allineate lungo corridoi. I passaggi e i singoli locali sono ricoperti da una volta a sesto acuto ottenuta mediante l'aggetto degli strati di pietre. Queste gallerie erano usate come magazzini difensivi per conservare provviste durante gli assedi.

Dobbiamo rappresentarci il coronamento delle mura come un cammino di ronda, costruito con mattoni crudi e travi. Alla fine del tredicesimo secolo avanti Cristo, le installazioni erano composte di tre parti: la rocca inferiore, a nord, che si estendeva lungo tutto lo sperone; la piccola rocca centrale, divisa dalla prima da forti mura e, a sud, la rocca superiore, che era la più fortificata, con il palazzo.

Il mito dei Ciclopi costruttori

Nella mitologia greca si diceva che la città avesse preso il nome da Tirinto, figlio di Argo e nipote di Zeus e Niobe. La tradizione associa le mura a Preto, figlio di Abante, il quale, inseguito da suo fratello Acrisio, fuggì in Licia. Con l'aiuto dei Lici, riuscì a tornare in Argolide. Lì, Preto occupò Tirinto e la fortificò con l'assistenza dei Ciclopi muratori detti Gasterochiri.

Pausania, scrittore e viaggiatore greco del secondo secolo dopo Cristo, ha dedicato un breve commento a Tirinto, scrivendo che le mura sono fatte di pietre rozze, e la grandezza di ciascuna di loro è tale, che una coppia di muli non potrebbe neppure smuovere un poco la più piccola di esse. Il termine deriva dalla convinzione dei greci classici che solo i mitici ciclopi avevano la forza di muovere gli enormi massi che costituivano queste mura.

L'importanza archeologica e architettonica

A Tirinto siamo di fronte all'ultima espressione, ma anche alla più spettacolare, di sistema murario megalitico dell'antico Mediterraneo. Edificate con blocchi di calcare non lavorati di dimensioni titaniche, alcuni pesano oltre dieci tonnellate, erano così massicce che gli autori successivi credevano non potessero essere state costruite da esseri umani.

L'architettura continentale micenea nell'organizzare le sue strutture difensive mostra i caratteri di una creazione originale con un rinnovato e peculiare modo di concepire ed eseguire l'opera muraria in pietra. Le mura di Tirinto rappresentano il culmine dell'ingegneria militare dell'età del bronzo, testimoniando la potenza e la sofisticatezza della civiltà micenea. Il sito archeologico continua a stupire visitatori e studiosi per l'imponenza delle sue fortificazioni megalitiche.

Di Alex (pubblicato @ 13:00:00 in Storia delle Invenzioni, letto 69 volte)

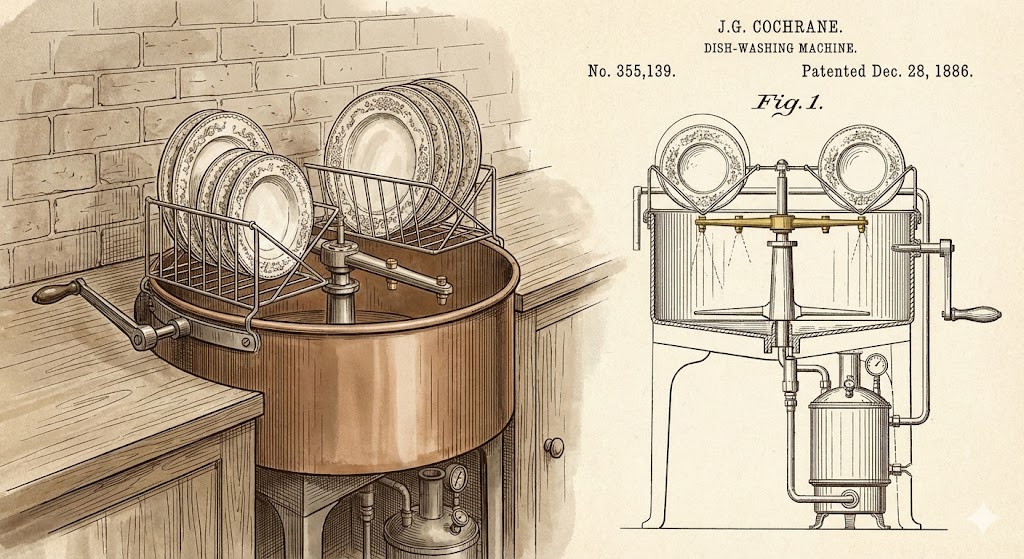

La prima lavastoviglie brevettata da Josephine Cochrane nel 1886

Nel milleottocentottantasei, un'ereditiera dell'Illinois rivoluzionò il lavaggio domestico non per pigrizia, ma per preservare le sue preziose porcellane cinesi. L'invenzione di Josephine Cochrane trasformò radicalmente l'igiene domestica e industriale, anticipando l'automazione del ventesimo secolo. LEGGI TUTTO L'ARTICOLO

La genesi di un'invenzione rivoluzionaria

Contrariamente allo stereotipo dell'inventore motivato dal risparmio di fatica personale, Josephine Cochrane era una ricca ereditiera che non lavava personalmente le stoviglie. La sua motivazione scaturiva dalla frustrazione verso il personale domestico, che scheggiava regolarmente le sue pregiate porcellane cinesi del diciassettesimo secolo durante il lavaggio manuale. Questa esigenza aristocratica innescò un processo innovativo che avrebbe trasformato l'economia domestica globale.

Nel milleottocentottantasei, Cochrane brevettò una macchina rivoluzionaria che utilizzava la pressione dell'acqua calda per pulire le stoviglie, abbandonando le spazzole meccaniche abrasive impiegate nei tentativi precedenti, che causavano danni alla superficie delle ceramiche. Il sistema prevedeva cestelli di filo metallico appositamente progettati per ospitare piatti, tazze e piattini in posizioni ottimali per massimizzare l'esposizione al getto d'acqua pressurizzata.

Meccanica e funzionamento del dispositivo

Il dispositivo originale era azionato manualmente o mediante un motore a vapore, rendendo l'apparecchio inadatto all'uso domestico medio dell'epoca, ma ideale per contesti commerciali. La camera di lavaggio era progettata per generare una pressione idraulica sufficiente a rimuovere residui alimentari senza contatto meccanico diretto, principio che rimane alla base delle lavastoviglie contemporanee.

La configurazione dei cestelli rappresentava un'innovazione ingegneristica significativa: la disposizione verticale delle stoviglie permetteva al getto d'acqua di raggiungere uniformemente tutte le superfici, mentre il design modulare consentiva l'adattamento a diversi formati di piatti e tazze. Questo approccio sistemico alla pulizia meccanizzata dimostrava una comprensione sofisticata della fluidodinamica, notevole per un'inventrice autodidatta dell'epoca.

Il debutto all'Esposizione Colombiana di Chicago

La presentazione della lavastoviglie all'Esposizione Colombiana di Chicago del milleottocentonovantatré segnò il punto di svolta commerciale. L'evento, che celebrava il quattrocentesimo anniversario della scoperta delle Americhe, fungeva da vetrina globale per le innovazioni tecnologiche. La dimostrazione pubblica della macchina attirò l'attenzione di proprietari di hotel e ristoratori, che necessitavano di soluzioni rapide e igieniche per gestire grandi volumi di stoviglie.

Il mercato istituzionale rappresentava il segmento ideale per l'adozione iniziale: gli esercizi commerciali disponevano dell'infrastruttura idraulica e della capacità economica necessarie per l'investimento. La macchina garantiva non solo efficienza temporale, ma anche standard igienici superiori, aspetto cruciale in un'epoca di crescente consapevolezza sanitaria nelle attività di ristorazione pubblica.

Industrializzazione e diffusione di massa

Josephine Cochrane fondò un'azienda manifatturiera che sarebbe successivamente confluita nel gruppo KitchenAid, brand che mantiene tuttora una posizione dominante nel mercato degli elettrodomestici. Tuttavia, la diffusione capillare nelle abitazioni private dovette attendere decenni. L'ostacolo principale era costituito dall'assenza di impianti idraulici ed elettrici standardizzati nelle case della classe media americana e europea.

Solo con l'urbanizzazione accelerata del ventesimo secolo e la costruzione di infrastrutture domestiche moderne, la lavastoviglie potè trasformarsi da lusso istituzionale a elettrodomestico domestico. Questo processo di democratizzazione tecnologica riflette un pattern ricorrente nell'innovazione: le tecnologie nate per élite economiche diventano accessibili alle masse quando l'ecosistema infrastrutturale raggiunge la maturità necessaria.

Impatto sociale ed economico dell'automazione domestica

L'invenzione di Cochrane rappresentò una pietra miliare nell'automazione del lavoro domestico, contribuendo alla liberazione di milioni di ore di lavoro manuale. Sebbene l'impatto immediato fosse limitato al personale domestico degli hotel e dei ristoranti, la diffusione successiva nelle case private ebbe conseguenze sociali profonde, particolarmente per le donne, tradizionalmente responsabili delle mansioni domestiche.

La riduzione del tempo dedicato alle faccende domestiche permise una maggiore partecipazione femminile al mercato del lavoro e all'istruzione superiore nel corso del ventesimo secolo. L'automazione domestica, iniziata con la lavastoviglie e proseguita con lavatrici, aspirapolvere e altri elettrodomestici, costituì un fattore abilitante per le trasformazioni sociali che ridefinirono i ruoli di genere nelle società industrializzate.

L'eredità di Josephine Cochrane trascende l'ambito dell'innovazione tecnologica per toccare dimensioni sociali ed economiche profonde. La sua invenzione dimostra come la risoluzione di un problema apparentemente marginale possa innescare trasformazioni sistemiche, quando la soluzione tecnica incontra le condizioni infrastrutturali e culturali appropriate per la diffusione. La lavastoviglie rimane un simbolo eloquente di come l'automazione possa ridefinire le economie domestiche e liberare tempo umano per attività più creative e produttive.

Metodologie scientifiche applicate all'indagine di fenomeni paranormali

L'indagine scientifica dei fenomeni paranormali richiede rigore metodologico e protocolli sperimentali riproducibili. Sebbene molti eventi considerati paranormali trovino spiegazioni naturali, l'applicazione del metodo scientifico permette di distinguere tra percezioni errate, frodi deliberate e anomalie genuine meritevoli di ulteriore studio. LEGGI TUTTO L'ARTICOLO

Il metodo scientifico applicato all'anomalo

L'indagine scientifica del paranormale non implica necessariamente l'accettazione dell'esistenza di fenomeni soprannaturali, ma richiede l'applicazione sistematica del metodo sperimentale a testimonianze e presunti eventi che sfidano le spiegazioni convenzionali. Il principio fondamentale è che qualsiasi fenomeno reale, indipendentemente da quanto inusuale, deve lasciare tracce misurabili e verificabili nella realtà fisica.

La prima fase di ogni indagine seria consiste nella raccolta di dati empirici attraverso strumentazione standardizzata: registratori audio e video, sensori ambientali per temperatura, campi elettromagnetici, pressione atmosferica e vibrazioni. Questi strumenti permettono di documentare oggettivamente le condizioni durante presunti eventi paranormali, eliminando l'elemento di testimonianza soggettiva che caratterizza gran parte delle segnalazioni.

Spiegazioni naturali per fenomeni apparentemente paranormali

La ricerca scientifica ha identificato numerose cause naturali per eventi comunemente percepiti come paranormali. Le infrastture acustiche, vibrazioni a frequenze inferiori ai venti hertz impercettibili consciamente all'orecchio umano, possono indurre sensazioni di disagio, ansia e persino allucinazioni visive. Queste onde sonore a bassa frequenza possono essere generate da fenomeni naturali come vento forte o attività sismica minore, o da sorgenti artificiali come impianti industriali.

I campi elettromagnetici variabili, prodotti da cablaggio elettrico difettoso o apparecchiature malfunzionanti, sono stati correlati a esperienze di presunta attività paranormale. Studi hanno dimostrato che l'esposizione a campi magnetici fluttuanti può stimolare specifiche aree del lobo temporale, generando sensazioni di presenza invisibile, esperienze mistiche e distorsioni percettive.

La pareidolia, tendenza del cervello umano a riconoscere pattern familiari in stimoli casuali, spiega numerosi avvistamenti di figure fantasmatiche in fotografie o ombre. Il sistema percettivo umano è evolutivamente programmato per identificare volti e forme antropomorfe anche in dati visivi ambigui, meccanismo che produceva vantaggi selettivi nel riconoscimento rapido di predatori o conspecifici.

Protocolli sperimentali per testare affermazioni paranormali

La verifica scientifica di affermazioni paranormali richiede protocolli sperimentali rigorosi che eliminano bias cognitivi e possibilità di frode. Il protocollo doppio cieco, dove né il soggetto testato né lo sperimentatore conoscono le condizioni specifiche del test, rappresenta lo standard per valutare presunte capacità extrasensoriali come telepatia, precognizione o chiaroveggenza.

Negli esperimenti di percezione extrasensoriale, i soggetti vengono posti in condizioni controllate e devono dimostrare capacità predittive o percettive statisticamente superiori al caso. Decenni di ricerca in laboratori accademici, inclusi gli studi condotti presso l'Università di Princeton e altre istituzioni, hanno consistentemente fallito nel produrre evidenze riproducibili di abilità paranormali che superino significativamente le previsioni probabilistiche casuali.

Neuroscienze e esperienze paranormali soggettive

Le neuroscienze cognitive hanno fornito spiegazioni dettagliate per molte esperienze soggettive interpretate come paranormali. Le esperienze di pre-morte, caratterizzate da sensazioni di distacco corporeo, movimento attraverso tunnel luminosi e incontri con entità, possono essere riprodotte attraverso stimolazione della giunzione temporo-parietale o in condizioni di ipossia cerebrale.

Gli stati alterati di coscienza indotti da privazione sensoriale, meditazione profonda o sostanze psicoattive possono generare esperienze fenomenologicamente indistinguibili da quelle interpretate come contatti spirituali o visioni mistiche. La ricerca ha identificato correlati neurali specifici per questi stati, suggerendo che rappresentino modalità alternative di processamento dell'informazione cerebrale piuttosto che accessi a dimensioni non fisiche.

Il ruolo della psicologia nella credenza paranormale

La psicologia cognitiva ha identificato numerosi bias che predispongono gli individui a interpretare eventi ordinari come paranormali. Il bias di conferma porta le persone a ricordare selettivamente eventi che confermano credenze preesistenti, ignorando controesempi. L'euristica della disponibilità fa sì che eventi rari ma emotivamente salienti vengano sovrastimati in termini di frequenza.

L'illusione di controllo e la tendenza a percepire pattern in sequenze casuali contribuiscono alla credenza in sincronicità significative e segni soprannaturali. Gli studi dimostrano che individui con elevata necessità di controllo e intolleranza all'ambiguità mostrano maggiore propensione a credenze paranormali, utilizzandole come meccanismo per imporre ordine percepito su eventi casuali.

Anomalie genuine e frontiere della ricerca

Nonostante la maggior parte dei fenomeni paranormali trovino spiegazioni convenzionali, esistono categorie di eventi anomali che meritano indagine scientifica continuata. Alcuni fenomeni di coscienza, come le rare ma documentate esperienze di consapevolezza durante arresto cardiaco completo, sollevano questioni interessanti sulla relazione tra attività cerebrale e coscienza soggettiva.

La fisica quantistica ha rivelato fenomeni che sfidano l'intuizione classica, come l'entanglement quantistico, sebbene non esistano evidenze che questi fenomeni possano essere sfruttati per comunicazione paranormale o influenza a distanza di sistemi macroscopici. La distinzione critica è tra fenomeni fisici controintuitivi ma scientificamente dimostrati e affermazioni paranormali prive di supporto empirico riproducibile.

L'approccio scientifico al paranormale non è dismissivo ma metodologicamente rigoroso. La scienza rimane aperta a qualsiasi fenomeno reale che possa essere oggettivamente documentato e studiato, indipendentemente da quanto inusuale. Tuttavia, affermazioni straordinarie richiedono evidenze straordinarie, e fino ad oggi la ricerca sistematica non ha prodotto prove convincenti per fenomeni che violino le leggi fisiche stabilite. Il valore dell'indagine scientifica risiede non solo nell'identificare frodi e errori percettivi, ma nel comprendere i meccanismi cognitivi e neurologici che generano esperienze interpretate come paranormali.

Le principali distribuzioni Linux e le loro caratteristiche distintive

Il panorama delle distribuzioni Linux offre soluzioni ottimizzate per differenti profili utente e casi d'uso. Le cinque distribuzioni più diffuse si distinguono per filosofia progettuale, gestione dei pacchetti, stabilità e facilità d'uso. Comprendere le peculiarità di ciascuna permette di identificare la soluzione più adeguata alle proprie esigenze. LEGGI TUTTO L'ARTICOLO

Ubuntu: accessibilità e supporto aziendale

Ubuntu rappresenta la distribuzione Linux più diffusa per desktop e una delle scelte predominanti per server e cloud computing. Sviluppata da Canonical, Ubuntu adotta un ciclo di rilascio semestrale con versioni LTS che garantiscono supporto esteso di cinque anni, rendendola ideale per ambienti aziendali che richiedono stabilità prolungata.

La filosofia progettuale di Ubuntu privilegia l'accessibilità agli utenti provenienti da sistemi operativi proprietari. L'ambiente desktop predefinito GNOME è stato estensivamente modificato per offrire un'esperienza intuitiva, mentre il gestore di pacchetti APT e il software center grafico semplificano l'installazione e l'aggiornamento del software. Ubuntu Software offre accesso sia ai repository tradizionali Debian che ai pacchetti Snap, formato containerizzato sviluppato da Canonical.

I punti di forza di Ubuntu includono la vastissima documentazione comunitaria, il supporto hardware eccellente grazie alla collaborazione diretta con produttori, e l'ecosistema di derivate ufficiali come Kubuntu, Xubuntu e Ubuntu Studio, ottimizzate per specifici casi d'uso. La presenza di Canonical garantisce supporto commerciale professionale, critico per adozioni enterprise.

Debian: stabilità e libertà software

Debian costituisce il fondamento di numerose distribuzioni derivate, inclusa Ubuntu stessa. La sua caratteristica distintiva è l'impegno rigoroso verso il software libero e la stabilità del sistema. Il progetto Debian è interamente guidato dalla comunità, senza sponsorizzazione aziendale diretta, seguendo contratti sociali che definiscono principi etici e tecnici.

Debian offre tre rami principali: Stable, Testing e Unstable. La versione Stable privilegia assolutamente la stabilità, includendo solo software estensivamente testato, con cicli di rilascio che possono estendersi per anni. Questo approccio conservativo la rende ideale per server di produzione e infrastrutture critiche dove l'affidabilità prevale sulla disponibilità immediata di software aggiornato.

Il sistema di gestione pacchetti APT di Debian è considerato uno dei più robusti e sofisticati, gestendo complesse dipendenze software con elevata affidabilità. Debian supporta un numero straordinario di architetture hardware, da sistemi embedded a mainframe, dimostrando versatilità tecnica eccezionale. La documentazione ufficiale è enciclopedica, sebbene richieda competenze tecniche per essere pienamente sfruttata.

Fedora: innovazione e integrazione upstream

Fedora serve come banco di prova per tecnologie che successivamente confluiranno in Red Hat Enterprise Linux. Sponsorizzata da Red Hat ma guidata dalla comunità Fedora Project, questa distribuzione privilegia l'adozione rapida di tecnologie emergenti e l'integrazione stretta con i progetti upstream del software libero.

Il ciclo di rilascio di Fedora è aggressivamente progressivo, con nuove versioni ogni sei mesi che incorporano le ultime versioni di kernel, ambiente desktop e toolchain di sviluppo. Questo la rende inadatta per sistemi che richiedono stabilità prolungata, ma eccellente per sviluppatori e utenti che desiderano accesso alle innovazioni più recenti.

Fedora ha storicamente pionerato l'adozione di tecnologie che sono diventate standard nel mondo Linux: systemd per la gestione dei servizi, Wayland come server grafico, PipeWire per l'audio, e Btrfs come filesystem predefinito. Il gestore di pacchetti DNF e il formato RPM offrono gestione robusta del software, mentre Flatpak fornisce accesso a applicazioni containerizzate cross-distribuzione.

Arch Linux: semplicità KISS e rolling release

Arch Linux adotta una filosofia radicalmente diversa, basata sul principio KISS: Keep It Simple, Stupid. La semplicità qui non significa facilità d'uso per principianti, ma architettura minimalista senza astrazioni inutili. Arch fornisce un sistema base minimale che l'utente costruisce incrementalmente secondo necessità specifiche.

Il modello rolling release elimina il concetto di versioni maggiori: il sistema è continuamente aggiornato con le ultime versioni del software. Questo garantisce accesso perpetuo alle innovazioni più recenti, ma richiede manutenzione attiva e comprensione tecnica per gestire occasionali incompatibilità. L'installazione iniziale avviene interamente da linea di comando, processo documentato nella leggendaria Arch Wiki, considerata una delle risorse più complete su Linux.

Il gestore di pacchetti Pacman è rinomato per velocità ed efficienza, mentre Arch User Repository permette alla comunità di condividere script di build per software non incluso nei repository ufficiali. Arch attrae utenti esperti che desiderano controllo granulare sul sistema e comprensione profonda dei meccanismi operativi sottostanti.

Linux Mint: raffinatezza per utenti desktop

Linux Mint è progettata esplicitamente per offrire un'esperienza desktop raffinata e immediatamente produttiva. Basata su Ubuntu ma con modifiche significative, Mint privilegia stabilità, eleganza visiva e inclusione di codec multimediali proprietari che Ubuntu esclude per ragioni ideologiche.

L'ambiente desktop Cinnamon, sviluppato dal team Mint, offre un paradigma di interazione tradizionale che risulta familiare agli utenti provenienti da Windows, riducendo drasticamente la curva di apprendimento. Le alternative MATE e Xfce sono disponibili per hardware meno potente. Mint include un ecosistema di strumenti proprietari per gestione sistema, backup e aggiornamenti, progettati per massimizzare semplicità senza sacrificare funzionalità.

La gestione degli aggiornamenti di Mint è particolarmente sofisticata, categorizzando i pacchetti per livello di rischio e permettendo all'utente di bilanciare sicurezza e stabilità. L'integrazione predefinita di driver proprietari, codec multimediali e software comunemente richiesto rende Mint immediatamente funzionale senza configurazione post-installazione, aspetto critico per utenti non tecnici.

Selezione della distribuzione appropriata

La scelta della distribuzione ottimale dipende da molteplici fattori: competenza tecnica, caso d'uso specifico, requisiti di stabilità e preferenze filosofiche. Ubuntu rappresenta il compromesso più equilibrato per la maggioranza degli utenti, offrendo accessibilità senza sacrificare potenza. Debian è preferibile per infrastrutture server critiche dove stabilità e prevedibilità sono priorità assolute.

Fedora attrae sviluppatori e early adopters che valorizzano l'accesso immediato a tecnologie emergenti. Arch Linux è destinata a utenti esperti che privilegiano controllo totale e comprensione sistemica profonda. Linux Mint offre la transizione più fluida per utenti provenienti da sistemi operativi proprietari, particolarmente in contesti desktop domestici o di piccoli uffici.

Il panorama delle distribuzioni Linux riflette la diversità dei casi d'uso e delle preferenze utente. Nessuna distribuzione è oggettivamente superiore in assoluto; ciascuna eccelle in specifici contesti. La ricchezza dell'ecosistema Linux risiede precisamente in questa pluralità, permettendo a organizzazioni e individui di identificare soluzioni perfettamente allineate con requisiti tecnici, filosofici e operativi. La sperimentazione diretta attraverso installazioni virtuali o live USB rappresenta il metodo più efficace per identificare la distribuzione più congeniale alle proprie esigenze.

Di Alex (pubblicato @ 10:00:00 in Storia delle Invenzioni, letto 73 volte)

Fotogramma storico dal film L'Inferno del 1911 con effetti speciali pioneristici

Il cinema, fin dalla genesi, ha assunto il ruolo di moderno aedo, raccogliendo l'eredità millenaria della narrazione mitologica. La sala cinematografica replica la caverna platonica, dove ombre e luci rivelano verità nascoste attraverso archetipi universali proiettati su scala globale. LEGGI TUTTO L'ARTICOLO

L'alba dei miti e l'architettura del silenzio: 1900-1929

Agli esordi, il cinema muto trovò nella mitologia un alleato formidabile. La grandiosità delle storie sopperiva alla mancanza della parola, permettendo ai registi di sperimentare con la scala visiva e i primi rudimentali effetti speciali. Il rapporto tra mythos e kinema è strutturale e ontologico: non si tratta meramente di adattare testi antichi, ma di reificare archetipi universali attraverso la tecnologia suprema della narrazione visiva.

L'Inferno 1911: il primo kolossal e la visione dantesca

Il primato del lungometraggio italiano spetta a L'Inferno del millenovecentoundici, prodotto dalla Milano Films. Diretto da Francesco Bertolini, Giuseppe De Liguoro e Adolfo Padovan, quest'opera rappresenta una pietra miliare non solo per la durata di oltre un'ora, ma per l'ambizione tecnica senza precedenti.

La direzione artistica scelse di aderire fedelmente alle celebri illustrazioni di Gustave Doré. Tuttavia, la trasposizione non fu statica. I registi impiegarono tecniche innovative per rendere il sovrannaturale: sovrimpressioni multiple per creare le anime trasparenti, l'uso di mascherini per alterare le proporzioni tra Dante e i giganti come Anteo, e prospettive forzate per le architetture infernali.

Analisi scenografica e tecnica del capolavoro muto

Lucifero fu rappresentato come una gigantesca creatura che mastica i traditori, realizzato con un misto di scenografia costruita e attori in costume, creando un effetto di grandiosità grottesca che definì lo standard per il fantastico europeo. Il film costò la stratosferica cifra di un milione di lire e richiese due anni di lavorazione.

I cinquantaquattro quadri si ispirano alle celebri incisioni di Doré, ma con precoci e impressionanti effetti speciali che ricordano quelli di Georges Méliès: personaggi che prendono il volo, animali in scena, corpi squartati e mutilati o in continua metamorfosi, creature mostruose rese con tecniche come doppie e triple sovrapposizioni. Tecniche che allora apparivano spettacolari e di enorme impatto visivo.

Il successo internazionale e l'eredità culturale

Il film ebbe un ampio successo anche all'estero e fu il primo a sfruttare un nuovo tipo di distribuzione inventato da Gustavo Lombardo, basato sulla cessione dei diritti in esclusiva per zone e paesi. La prima proiezione pubblica avvenne il primo marzo millenovecentoundici al Teatro Mercadante di Napoli, alla presenza di Benedetto Croce, Roberto Bracco e Matilde Serao.

Matilde Serao scrisse che il film della Milano per L'Inferno di Dante ha riabilitato il cinematografo, trasformandolo in un vero palpito di curiosità e di emozione. L'obiettivo di fare del cinema una forma d'arte a tutti gli effetti era stato raggiunto in pieno.

L'Inferno della Milano Films rimane probabilmente la migliore traduzione cinematografica dei versi di Dante. Questo film dimostra come ogni avanzamento tecnologico abbia permesso di visualizzare una nuova facciata del prisma mitologico, dall'artigianalità della stop-motion alla fluidità algoritmica della computer grafica contemporanea.

Vista aerea dell'Arena di Verona con le caratteristiche mura in pietra della Valpolicella

Costruita nel primo secolo dopo Cristo con pietra della Valpolicella, l'Arena di Verona è sopravvissuta grazie alla continua utilizzazione. Situata strategicamente nel nord Italia, serviva a intrattenere le truppe e a marcare la presenza romana nelle terre cisalpine. LEGGI TUTTO L'ARTICOLO

La costruzione strategica fuori dalle mura

L'anfiteatro veronese sorse a circa settanta-ottanta metri dalle mura repubblicane della città, di fronte all'angolo formato dalla cinta cittadina a meridione. Questo evidenzia il fatto che non era stato previsto nel progetto originario della città. La metà del primo secolo avanti Cristo fu un periodo di guerre civili, quindi non era realistica la costruzione di un edificio tanto imponente vicino alle mura, che avrebbe indebolito il sistema difensivo.

Si conclude quindi che l'opera venne costruita in un periodo di pace, che coincide quasi sicuramente con l'inizio dell'età imperiale, attorno alla metà del primo secolo dopo Cristo. L'Arena fu edificata all'esterno delle mura della città romana per favorire l'afflusso degli spettatori ed evitare affollamenti nel centro urbano.

Architettura e materiali di costruzione

Questo imponente anfiteatro, per dimensioni, è uno degli esempi più prestigiosi e importanti dell'architettura e dell'ingegneria romana. Costruito in calcare della Valpolicella, oggi dell'anello esterno originale rimane la cosiddetta Ala, caratterizzata da arcate a tre ordini, sopra le quali sono conservate le indicazioni numeriche che favorivano l'ingresso ordinato degli spettatori.

La forma ellittica è concepita per accogliere un gran numero di spettatori, circa trentamila, e per dare ai giochi spazio sufficiente. Le misure totali dell'anfiteatro sono centocinquantadue per centoventitre metri circa. Di questi, l'Arena occupa una superficie di settantacinque per quarantaquattro metri circa, mentre la cavea è larga una quarantina di metri.

La funzione nell'impero romano

In questo edificio si svolgevano diversi tipi di spettacolo: combattimenti tra gladiatori e cacce ad animali feroci ed esotici. Verona era situata in una posizione strategica lungo l'Adige ed era attraversata dalla via Claudia Augusta, una strada che portava al Passo del Brennero e consentiva i collegamenti con il nord Europa. Per questi motivi, Verona era una città molto frequentata e l'Arena è stata costruita per accogliere un alto numero di spettatori che non erano solo i suoi cittadini.

Sopravvivenza attraverso i secoli

Dell'anello esterno dell'Arena, che ne costituiva la facciata, si conserva solo un breve tratto. Sotto il regno di Teodorico, tra il quattrocentonovantatré e il cinquecentoventisei dopo Cristo, l'anello esterno fu in parte demolito per la costruzione della seconda cinta muraria della città e, fino al Rinascimento, l'Arena fu usata come cava di pietra.

A partire dall'età medievale gli arcovoli esterni vennero dati in affitto dal Comune: fino al sedicesimo secolo vi furono relegate le prostitute mentre, in epoca successiva, vi trovarono posto botteghe artigiane. Lo spazio interno fu adibito nel corso del tempo a diversi usi, come l'amministrazione della giustizia, feste, spettacoli, corse.

La rinascita moderna: dal 1913 al festival lirico

Fu l'anno millenovecentotredici che vide la prima rappresentazione di un'opera all'interno dell'Arena: era l'Aida di Giuseppe Verdi, e da allora questo monumento divenne la sede e il simbolo della stagione lirica estiva veronese, rassegna famosa in tutto il mondo.

L'anfiteatro ha continuato a ospitare spettacoli ed eventi nel corso dei secoli, ed è ancora oggi famoso in tutto il mondo per l'Arena di Verona Opera Festival. È uno degli anfiteatri antichi giunto a noi con il miglior grado di conservazione, grazie ai sistematici restauri eseguiti fin dal Cinquecento e alla sua continua utilizzazione funzionale.

Di Alex (pubblicato @ 08:00:00 in Smartphone, letto 70 volte)

Antica tavoletta medica con simboli di erbe curative e strumenti chirurgici primitivi

L'evoluzione della medicina riflette una trasformazione profonda: da visione magico-religiosa della malattia come perturbazione cosmica, a decodifica sistematica dei meccanismi biochimici. Il percorso millenario ha visto il passaggio da rituali e incantesimi a farmacologia molecolare di precisione. LEGGI TUTTO L'ARTICOLO

Il retaggio dell'antichità: tra magia, erbe e teoria umorale

Prima della nascita di un approccio scientifico, le pratiche mediche erano intrinsecamente legate a una visione olistica e trascendente. Nelle società primitive e nelle prime civiltà, l'origine del malessere veniva ricercata in influenze demoniache, punizioni divine o squilibri spirituali. Presso gli antichi Ebrei, l'esercizio della medicina era prerogativa della classe sacerdotale, e le pratiche di guarigione includevano riti apotropaici e sacrifici animali intesi come atti di espiazione.

Nonostante questa cornice spirituale, esisteva un bagaglio di sapienza intuitiva ed empirica che permetteva di riconoscere in minerali ed erbe specifiche proprietà lenitive. Gli antichi Egizi e le culture orientali integravano incantesimi e preghiere con una farmacopea vegetale sorprendentemente vasta, intuendo che lo stile di vita e l'ambiente potessero influenzare il decorso di una patologia.

Ippocrate di Coo: la rivoluzione razionalista

Il primo vero tentativo di razionalizzazione del pensiero medico in Occidente si deve a Ippocrate di Coo nel quinto secolo avanti Cristo. Ippocrate operò una separazione fondamentale: la malattia non era più un fenomeno sacro, ma un evento naturale derivante da cause fisiche identificabili. La sua Teoria degli Umori divenne il pilastro della medicina per oltre millecinquecento anni.

Questa dottrina ipotizzava che la salute risiedesse nel perfetto equilibrio, o eucrasia, di quattro fluidi corporei fondamentali: il sangue prodotto dal cuore, la flemma dal cervello, la bile gialla dal fegato e la bile nera dalla milza. La discrasia, ovvero lo squilibrio di questi umori, era causata da fattori esterni come il clima o l'alimentazione.

Il sistema galeniano e il dogma millenario

Galeno, nel secondo secolo dopo Cristo, sistematizzò ulteriormente questa visione, associando a ciascun umore un temperamento: sanguigno, flemmatico, collerico, malinconico. Definì pratiche terapeutiche basate sul principio dei contrari. Sebbene questo approccio cercasse una logica interna, esso poggiava su presupposti anatomici spesso errati, derivati dalla dissezione di animali, e su una rigidità dogmatica che avrebbe frenato l'innovazione fino al Rinascimento.

La terapia ippocratica consisteva nel promuovere la vis medicatrix naturae, la forza curatrice della natura, attraverso diete, purghe e salassi per eliminare gli umori in eccesso. Questo paradigma dominò incontrastato il pensiero medico occidentale fino all'avvento dell'anatomia moderna con Andreas Vesalius nel sedicesimo secolo.

Dalla teoria umorale alla biomedicina molecolare

La dissoluzione del paradigma umorale fu graduale ma inesorabile. Il Rinascimento portò la dissezione anatomica sistematica, il diciassettesimo secolo vide la scoperta della circolazione sanguigna di Harvey, il diciannovesimo secolo introdusse la teoria dei germi di Pasteur e Koch. Il ventesimo secolo coronò questa evoluzione con la scoperta degli antibiotici, dei vaccini e della struttura del DNA.

Oggi la medicina di precisione, basata sulla genomica e sulla farmacologia molecolare, rappresenta il culmine di questo percorso millenario. L'antica intuizione ippocratica dell'individualità della malattia trova nuova espressione nella terapia personalizzata, mentre la vis medicatrix naturae si è trasformata nella comprensione dei meccanismi di autoregolazione immunitaria e cellulare.

Di Alex (pubblicato @ 07:00:00 in Intelligenza Artificiale, letto 85 volte)

Le origini e la filosofia di Deepseek

Fondata dall'azienda cinese DeepSeek (nota anche come Depthseek o Deep Seek), la piattaforma nasce con una missione chiara: rendere l'intelligenza artificiale generale (AGI) accessibile e benefica per l'umanità. A differenza di molti concorrenti, Deepseek ha puntato fin dall'inizio sull'apertura, rilasciando in open source diversi modelli precedenti e mantenendo un accesso gratuito e senza barriere alla sua interfaccia chat principale. Questa scelta riflette un approccio pragmatico e orientato alla comunità, volto ad accelerare la ricerca e l'adozione pratica dell'AI.

Capacità tecniche e punti di forza distintivi

Deepseek Chat si distingue per un insieme robusto di funzionalità che competono alla pari con le migliori offerte globali.

- Ragionamento e problem solving complesso: Eccelle nella risoluzione di problemi logici, matematici e scientifici, mostrando una notevole capacità di pensiero astratto e deduzione.

- Generazione e spiegazione del codice: Supporta decine di linguaggi di programmazione, aiutando gli sviluppatori a scrivere, debugare, ottimizzare e commentare il codice in modo efficiente.

- Elaborazione contestuale estesa: Gestisce contesti lunghi (fino a 128K token nelle versioni più avanzate), permettendo l'analisi di documenti estesi, trascrizioni di riunioni o interi libri in una singola conversazione.

- Analisi multimodale (upload file): Può leggere e processare il contenuto di file caricati dall'utente, tra cui immagini (estraendo testo), documenti PDF, presentazioni PowerPoint, fogli Excel e file Word, trasformandoli in informazioni e risposte strutturate.

- Ricerca web in tempo reale: Una funzionalità opzionale che, se attivata dall'utente, permette all'assistente di accedere alle informazioni più recenti da internet, superando il limite della conoscenza pre-addestrata.

Confronto prestazionale: Deepseek vs Modelli Occidentali

Benchmark indipendenti collocano i modelli di Deepseek, in particolare DeepSeek-V2 e DeepSeek Coder, ai vertici delle classifiche globali in categorie specifiche.

| Aspetto | Deepseek (Cina) | Modelli Occidentali (es. GPT-4, Claude) |

| Accesso Gratuito | Pieno e senza limiti stringenti per la chat base. | Limitato (versioni freemium) o a pagamento. |

| Efficienza Costi/Performance | Architettura Mixture-of-Experts (MoE) per alte prestazioni a costi ridotti. | Modelli densi spesso più costosi da far funzionare. |

| Capacità di Codice | Eccellente, specializzato (DeepSeek-Coder). | Eccellente, ma generalista. |

| Lunghezza Contesto | Fino a 128K token, competitiva. | Da 128K a 200K token. |

| Multimodalità Nativa | Input di file (testo da immagini/doc). | Input nativo di immagini, audio, video. |

| Open Source | Storico di release open source per modelli precedenti. | Modelli principali closed-source. |

Il futuro è già qui: roadmap e previsioni

La traiettoria di Deepseek punta decisamente verso l'eccellenza assoluta. Le previsioni per i prossimi 12-24 mesi includono:

- Modelli sempre più potenti ed efficienti: Ulteriore sviluppo dell'architettura Mixture-of-Experts per superare i limiti degli attuali modelli densi, offrendo capacità vicine a GPT-4 a una frazione del costo computazionale.

- Multimodalità avanzata: Integrazione nativa della generazione e comprensione di immagini, audio e potenzialmente video, colmando il gap attuale con alcuni competitor.

- Specializzazione verticale: Lancio di modelli finetunati per settori specifici come legge, medicina, finanza e ingegneria, con un focus particolare sul mercato cinese e asiatico.

- Maggior integrazione con l'ecosistema tech cinese: Collaborazioni più strette con aziende come Huawei, Alibaba Cloud e Tencent per ottimizzare l'hardware e la distribuzione.

- Verso l'AGI: Ricerca continua verso meccanismi di ragionamento più simili a quelli umani, pianificazione a lungo termine e apprendimento continuo.

Deepseek non è solo un'altra intelligenza artificiale. È la dimostrazione tangibile della capacità cinese di innovare e competere nella tecnologia più avanzata del nostro tempo. Con una combinazione vincente di potenza, efficienza, filosofia open e una visione chiara del futuro, si sta ritagliando un ruolo da protagonista nello scenario globale dell'AI. Per sviluppatori, ricercatori e utenti curiosi, rappresenta oggi una delle opzioni più valide e promettenti, portando avanti con orgoglio il concetto di "AI made in China".

Fotografie del 06/02/2026

Nessuna fotografia trovata.

Think different!

Think different!

Microsmeta Podcast

Microsmeta Podcast Feed Atom 0.3

Feed Atom 0.3

(p)Link

(p)Link Commenti

Commenti Storico

Storico Stampa

Stampa