\\ Home Page : Articolo

HANNO SUPPORTATO DIGITAL WORLDS INVIANDO PRODOTTI DA RECENSIRE

|

|

|

|

|

Paradigmi evolutivi nell'ingegneria dei motori scacchistici: oltre l'orizzonte nnue

Di Alex (del 20/12/2025 @ 14:00:00, in Intelligenza Artificiale e scacchi, letto 329 volte)

Il cervello digitale di un motore scacchistico moderno

L'integrazione delle reti NNUE in Stockfish 12 ha rivoluzionato gli scacchi computerizzati unendo la velocità delle CPU alla generalizzazione del Deep Learning. Tuttavia, l'architettura attuale si avvicina a un plateau. Questo report esplora strategie avanzate come architetture ibride Alpha-Beta/MCTS, search-contempt e gestione hardware dinamica per spingere i motori oltre i limiti attuali. LEGGI TUTTO L'ARTICOLO

1. Introduzione: La convergenza asintotica della potenza scacchistica

L'evoluzione dei motori scacchistici ha visto il transito dai sistemi esperti basati sulla logica simbolica alle moderne architetture neurali. Per decenni, il dominio è stato retto dal paradigma della forza bruta computazionale, incarnato dalla ricerca Alpha-Beta abbinata a funzioni di valutazione manuali (HCE). L'agosto del 2020 ha segnato un punto di flesso irreversibile con l'integrazione delle Reti Neurali Efficientemente Aggiornabili (NNUE) all'interno di Stockfish 12. Questa innovazione ha permesso di coniugare la velocità di esecuzione su CPU delle architetture classiche con la capacità di generalizzazione e pattern recognition tipica del Deep Learning, portando a un incremento immediato e massiccio della forza di gioco.

Oggi, Stockfish NNUE domina incontrastato le classifiche mondiali. Tuttavia, l'analisi delle curve di progresso recenti suggerisce che l'attuale architettura stia raggiungendo un plateau asintotico. I guadagni, pur presenti, richiedono sforzi esponenzialmente maggiori in termini di ingegneria dei dati e ottimizzazione hardware. Questo rapporto tecnico si propone di decostruire lo stato dell'arte e di indagare le strategie che un'Intelligenza Artificiale avanzata potrebbe adottare per spingere un motore NNUE oltre i suoi attuali limiti teorici e fisici.

L'indagine esplorerà una rifondazione strutturale del motore. Analizzeremo l'adozione di architetture ibride che fondono Alpha-Beta e Monte Carlo Tree Search (MCTS) attraverso framework modulari (M2CTS), l'implementazione di meccanismi di Search-Contempt per rivoluzionare i regimi di addestramento, e la gestione adattiva delle risorse hardware per mitigare i fenomeni di thermal throttling indotti dalle istruzioni AVX-512. Inoltre, affronteremo le debolezze sistemiche dell'architettura attuale, come la cecità alle fortezze e le imprecisioni nei finali complessi, proponendo soluzioni basate su Mixture of Experts (MoE) e reti ausiliarie specializzate.

2. Fondamenta architetturali: decostruzione del paradigma nnue

Per comprendere come migliorare Stockfish, è imperativo dissezionare le meccaniche che governano la sua attuale supremazia. L'efficienza di NNUE non risiede nella profondità della rete, ma nella sua architettura sparsa e incrementale, progettata specificamente per sfruttare la natura del gioco degli scacchi, dove la differenza tra due posizioni consecutive è minima.

2.1 L'evoluzione della feature factorization: da halfkp a halfkav2

Il cuore pulsante di NNUE è il Feature Transformer, un componente che mappa la rappresentazione grezza della scacchiera in uno spazio latente denso. A differenza delle reti convoluzionali profonde (DCNN) utilizzate da Leela Chess Zero (Lc0), NNUE aggiorna solo i neuroni relativi ai pezzi che si sono mossi, sfruttando accumulatori persistenti.

2.1.1 Il modello halfkp: la genesi

La struttura originale, denominata HalfKP (Half King-Piece), deriva dai motori di Shogi. L'input è codificato come un vettore sparso binario. Per ogni lato, la rete considera la posizione del proprio Re in relazione a tutti gli altri pezzi. Questo genera uno spazio di input di oltre 40.000 dimensioni. L'aggiornamento dell'accumulatore avviene tramite una differenza incrementale puramente additiva, estremamente efficiente su CPU moderne.

2.1.2 Halfkav2 e la compressione semantica

L'evoluzione verso HalfKAv2 ha introdotto una maggiore complessità semantica per catturare interazioni più sottili, espandendo lo spazio di input e mappandolo in un layer lineare più ampio. Un elemento critico di ottimizzazione è il Virtual Feature Coalescing, che mappa feature simmetriche sullo stesso indice di peso per ridurre la ridondanza dei parametri e mantenere il modello abbastanza piccolo da risiedere nella cache della CPU.

2.2 Quantizzazione e aritmetica a bassa precisione

L'efficienza computazionale di NNUE è legata all'uso di aritmetica intera a bassa precisione (int16 e int8) invece dei numeri in virgola mobile a 32 bit. La funzione di attivazione ClippedReLU mantiene i valori in un intervallo compatibile con i registri a 8 bit firmati. Questo permette l'utilizzo di istruzioni SIMD avanzate come AVX2 e AVX-512. Stockfish utilizza schemi di quantizzazione post-training o Quantization Aware Training (QAT) per mitigare il rumore introdotto dalla bassa precisione.

Ecco un riepilogo delle caratteristiche tecniche delle architetture NNUE:

- HalfKP: Input 41.024 x 2, Hidden Layer 256, Output 1, Precisione int16/int8. Prima implementazione basata su King-Piece.

- HalfKA: Input 45.056 x 2, Hidden Layer 256, Output 1, Precisione int16/int8. Introduce feature più complesse.

- HalfKAv2: Input 45.056 x 2, Hidden Layer 512, Output 1, Precisione int16/int8. Maggiore larghezza del layer e feature coalescing.

- Big Refactor: Dimensioni variabili, Output multiplo, Precisione int8/int8. Supporto per reti più grandi e layer extra.

La dipendenza dalla CPU e dalla memoria cache pone un limite fisico alla crescita della rete: reti troppo grandi causano cache miss frequenti, facendo crollare la velocità di analisi.

3. Il limite dell'hardware e l'ottimizzazione a basso livello

Per spingere Stockfish oltre i suoi limiti attuali, è necessario ottimizzare l'interazione tra il software e il silicio. L'introduzione di set di istruzioni complessi come AVX-512 ha creato nuove opportunità ma anche sfide termiche.

3.1 Istruzioni simd: avx2 vs avx-512 vnni

Le moderne CPU offrono estensioni vettoriali per parallelizzare il calcolo. AVX2 opera su registri a 256 bit ed è lo standard per l'efficienza. AVX-512 estende i registri a 512 bit, raddoppiando teoricamente il throughput. VNNI è un'estensione specifica per il Deep Learning che accelera ulteriormente le operazioni su interi a 8 bit. Tuttavia, l'uso di AVX-512 può causare il fenomeno del frequency throttling.

3.2 Il paradosso del throttling e la gestione termica

Quando una CPU esegue istruzioni AVX-512 pesanti, la densità di potenza dissipata aumenta e il gestore di potenza riduce la frequenza di clock per proteggere il chip. Questo crea un paradosso: la parte NNUE diventa più veloce grazie al parallelismo, ma la parte di ricerca Alpha-Beta, che dipende dalla frequenza di clock, rallenta. Se il guadagno della rete non compensa la perdita della ricerca, la forza di gioco totale diminuisce.

3.3 Strategie di kernel switching dinamico

Una AI avanzata implementerebbe una strategia hardware-aware dinamica. Il motore dovrebbe integrare molteplici kernel di inferenza (AVX2, AVX-512) e un modulo di supervisione che monitora la frequenza operativa in tempo reale. Se viene rilevato un downclock penalizzante, il motore commuta automaticamente su un kernel più leggero o intervalla le istruzioni pesanti con codice scalare per evitare il throttling aggressivo.

3.4 Ottimizzazione della cache e memory layout

Con l'aumento delle dimensioni delle reti, mantenere i pesi nella cache diventa difficile. Una strategia di miglioramento è la Quantizzazione Differenziata, che mantiene alta precisione solo per il primo layer e comprime ulteriormente i successivi. Inoltre, è cruciale riorganizzare il layout in memoria dei pesi per massimizzare la località spaziale durante l'accesso.

4. Ibridazione algoritmica: alpha-beta incontra mcts

Mentre l'ottimizzazione hardware fornisce la velocità, l'architettura di ricerca fornisce l'intelligenza. La prossima frontiera risiede nell'unire la precisione tattica di Alpha-Beta con la comprensione posizionale probabilistica del Monte Carlo Tree Search (MCTS).

4.1 M2cts: modularità e mixture of experts (moe)

L'approccio monolitico di una singola rete NNUE costringe a un compromesso medio tra le diverse fasi della partita. La ricerca recente propone l'adozione di un framework M2CTS (Modular MCTS), che integra il concetto di Mixture of Experts (MoE).

4.1.1 Architettura a gate neurale

L'implementazione prevede un insieme di reti specializzate (Esperti per apertura, mediogioco, finale) e una Gating Network che assegna un peso a ciascun esperto in base allo stato della scacchiera. Il gate neurale rileva transizioni di fase basate sulla struttura della posizione. Per mantenere la velocità, il gate viene calcolato solo quando la posizione cambia drasticamente.

4.2 Search-contempt: rivoluzionare l'addestramento e la ricerca

Il concetto di Search-Contempt offre una leva potente per migliorare la qualità del gioco e dell'addestramento.

4.2.1 Teoria del search-contempt

Nel self-play standard, la ricerca della mossa oggettivamente migliore porta spesso a patte sterili. Il Search-Contempt modifica l'algoritmo durante l'addestramento introducendo un campionamento probabilistico distorto per le mosse dell'avversario. Questo simula un avversario imperfetto che esplora varianti rischiose, costringendo il motore che apprende a trovare refutazioni precise in posizioni complesse e arricchendo il dataset.

4.2.2 Applicazione in partita (contempt dinamico)

In partita, il motore può usare una policy ibrida che penalizza le mosse che semplificano troppo la posizione a meno che non siano decisamente vincenti, massimizzando le probabilità di errore dell'avversario in posizioni complicate.

4.3 Policy network ausiliarie per il move ordering

Un miglioramento strutturale è l'introduzione di una Policy Network leggera, distinta dalla rete di valutazione. Questa rete predice la mossa più probabile di un esperto e viene usata per ordinare le mosse nel nodo Alpha-Beta. Se accurata, permette alla ricerca di raggiungere profondità maggiori nello stesso tempo.

5. Domini di specializzazione e anomalie semantiche

Stockfish NNUE soffre ancora di cecità in domini dove la valutazione locale fallisce nel catturare vincoli globali.

5.1 Il problema delle fortezze (fortress blindness)

Una fortezza è una posizione di svantaggio materiale con una barriera difensiva impenetrabile. Le reti NNUE faticano a rilevare questi schemi a lungo raggio, spesso valutandoli erroneamente come vincenti.

5.1.1 Soluzione: modulo oracolo transformer

La strategia ottimale è l'uso di un Oracolo Asincrono basato su Transformer. Se un nodo di ricerca raggiunge una profondità elevata con valutazione alta ma senza progressi concreti, viene analizzato dalla rete specializzata. Se questa rileva una fortezza, la valutazione viene sovrascritta a parità, prevenendo l'effetto orizzonte.

5.2 Specializzazione nei finali (endgame specialization)

La zona tra 8 e 12 pezzi è critica per le tablebase e l'euristica generale. L'approccio MoE trova qui applicazione creando dataset di training composti esclusivamente da finali complessi e addestrando una sotto-rete specializzata per imparare concetti fini che si perdono nelle reti generaliste.

6. Ingegneria dei dati e regimi di addestramento

La qualità di un motore AI è limitata dalla qualità dei dati su cui apprende.

6.1 Fixed nodes vs fixed depth: il determinismo nell'addestramento

Per la generazione dei dati di training, l'evidenza tecnica favorisce l'uso di Fixed Nodes (numero fisso di nodi di ricerca) rispetto a Fixed Depth (profondità fissa). Fixed Nodes garantisce un budget computazionale uniforme per ogni data point, assicurando riproducibilità e coerenza statistica indipendentemente dall'hardware utilizzato.

6.2 Deep feature reweighting (dfr) e correzione del bias

I dataset da self-play soffrono di bias di conferma. La tecnica DFR propone di identificare le classi di posizioni con alto errore di predizione e assegnare loro un peso maggiore durante il training. Questo forza la rete a concentrarsi sulle sue debolezze piuttosto che sovra-ottimizzare ciò che già conosce.

6.3 Odds chess come acceleratore di apprendimento

L'uso di partite Odds Chess (con handicap materiale) costringe il motore a sviluppare uno stile di gioco estremamente attivo per sopravvivere contro avversari forti. Le reti addestrate in questo modo mostrano una comprensione superiore del valore relativo dei pezzi e dell'attività quando riportate al gioco normale.

7. Prospettive future e conclusioni

L'analisi delinea un percorso per l'evoluzione dei motori NNUE che passa dal modello monolitico a sistemi modulari e ibridi. Le strategie chiave includono architetture M2CTS con Mixture of Experts, integrazione di logiche probabilistiche nella ricerca (Hybrid Search), gestione attiva delle risorse hardware, ingegneria dei dati avanzata e l'uso di oracoli semantici per anomalie posizionali.

L'implementazione di queste strategie richiede una complessità ingegneristica notevolmente superiore all'attuale, ma rappresenta l'unica via per trasformare Stockfish da un calcolatore sovrumano a un'entità dotata di una forma di comprensione scacchistica profonda e contestuale. Il motore totale del futuro non si limiterà a calcolare la mossa migliore; capirà la posizione in un modo che fonde la precisione della macchina con l'intuizione di livello superiore.

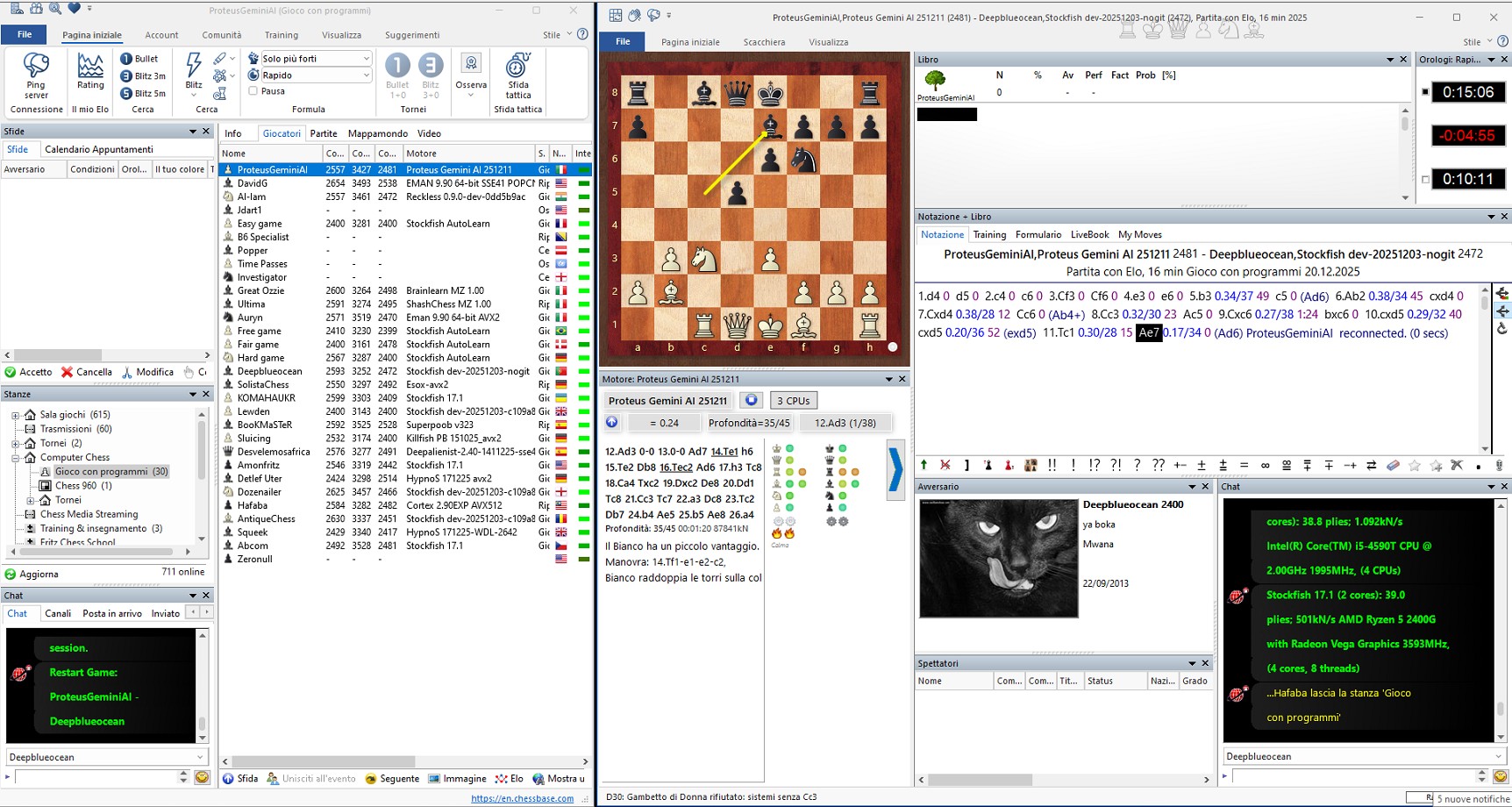

Una sessione di test attivo: noi contro ProteusGeminiAI, un'implementazione sperimentale dei paradigmi evolutivi discussi nel report.

Nessun commento trovato.

Disclaimer

L'indirizzo IP del mittente viene registrato, in ogni caso si raccomanda la buona educazione.

L'indirizzo IP del mittente viene registrato, in ogni caso si raccomanda la buona educazione.

Think different!

Think different!

Microsmeta Podcast

Microsmeta Podcast Feed Atom 0.3

Feed Atom 0.3

Articolo

Articolo  Storico

Storico Stampa

Stampa