\\ Home Page : Pubblicazioni

Di seguito gli articoli e le fotografie pubblicati nella giornata richiesta.

Articoli del 19/01/2026

Di Alex (pubblicato @ 11:00:00 in Tecnologia, letto 0 volte)

Le imponenti rovine delle Terme di Caracalla con le maestose volte e i resti degli ambienti termali monumentali

Inaugurate nel 216 d.C., le Terme di Caracalla potevano accogliere 1.600 persone contemporaneamente. Questi complessi ciclopici non erano semplici bagni pubblici, ma veri centri culturali con biblioteche e giardini, offerti dall'imperatore per placare la plebe in un perfetto esempio di edonismo di Stato. LEGGI TUTTO L'ARTICOLO

Un colosso di marmo e concrete

Le Terme di Caracalla, conosciute nell'antichità come Thermae Antoninianae, rappresentano uno dei complessi architettonici più maestosi mai costruiti dall'Impero Romano. Inaugurate dall'imperatore Caracalla nel 216 d.C., si estendevano su un'area di circa 13 ettari, di cui 6 occupati dall'edificio termale vero e proprio e il resto da giardini, porticati e servizi.

La capacità ricettiva era straordinaria: fino a 1.600 persone potevano frequentare contemporaneamente i vari ambienti. Le rovine ciclopiche che vediamo oggi, con mura alte fino a 38 metri e volte crollate che giaciono come giganteschi pezzi di puzzle in laterizio, permettono di comprendere la vastità e l'ambizione ingegneristica di questo progetto monumentale.

Il complesso termale era costruito secondo un asse simmetrico rigoroso. Al centro si trovava il frigidarium, la grande sala fredda con vasche di acqua gelida, circondata da due palestre all'aperto. Da un lato il tepidarium con acqua tiepida, dall'altro il calidarium, la sala caldissima coronata da una cupola enorme che rivaleggiava con quella del Pantheon.

L'ingegneria idraulica sotterranea

Ciò che rende le Terme di Caracalla un capolavoro ingegneristico non è visibile dalla superficie. Sotto i pavimenti marmorei si estendeva un complesso sistema di gallerie sotterranee alte fino a 6 metri, dove centinaia di schiavi alimentavano continuamente i forni che riscaldavano l'acqua e producevano il vapore.

L'acqua proveniva dall'Aqua Antoniniana, un ramo dell'Aqua Marcia costruito appositamente per le terme. Ogni giorno affluivano circa 80.000 metri cubi di acqua fresca, distribuita attraverso una rete di tubazioni in piombo e terracotta che alimentavano piscine, fontane e le varie vasche termali.

Il sistema di riscaldamento ipocausto era una meraviglia tecnica. Il pavimento era sostenuto da pilastrini di mattoni che creavano un'intercapedine dove circolava aria calda proveniente dai forni. Anche le pareti erano cave, con tubi di terracotta che permettevano al calore di salire, riscaldando uniformemente gli ambienti. Questo sistema permetteva di mantenere temperature differenziate nelle varie sale, dal freddo glaciale del frigidarium ai 40-50 gradi del calidarium.

Centri culturali, non solo bagni

Le terme romane non erano semplici luoghi per l'igiene personale, ma veri centri sociali e culturali che svolgevano una funzione fondamentale nella vita urbana. Le Terme di Caracalla includevano due biblioteche, una greca e una latina, collocate in ambienti simmetrici ai lati del complesso, dove i frequentatori potevano leggere e studiare dopo il bagno.

I giardini esterni erano decorati con centinaia di statue, molte delle quali capolavori dell'arte greca importati dall'Oriente o copie romane di opere famose. Il Toro Farnese e l'Ercole Farnese, oggi al Museo Archeologico di Napoli, furono rinvenuti proprio tra queste rovine. Fontane, ninfei e portici offrivano zone d'ombra dove passeggiare e conversare.

Le palestre permettevano di praticare esercizio fisico, mentre ambienti dedicati ospitavano massaggi, trattamenti di bellezza e persino piccole rappresentazioni teatrali. Le terme erano aperte a tutti i cittadini romani gratuitamente o per una cifra simbolica, una politica di evergetismo imperiale che trasformava questi complessi in strumenti di consenso politico.

Panem et circenses: placare la plebe

La costruzione di terme così monumentali rispondeva a una precisa strategia politica riassunta dalla celebre espressione panem et circenses, pane e giochi circensi. Gli imperatori romani comprendevano che per mantenere stabile una metropoli di oltre un milione di abitanti servivano non solo distribuzioni gratuite di grano, ma anche luoghi dove la popolazione potesse svagarsi e sentirsi parte della grandezza di Roma.

Le terme offrivano alla plebe urbana, spesso povera e ammassata in insulae sovraffollate prive di servizi igienici, la possibilità di accedere a un lusso che altrimenti sarebbe stato appannaggio esclusivo dei ricchi. Per alcune ore al giorno, un cittadino romano poteva immergersi in vasche di marmo, camminare tra statue greche e leggere nelle biblioteche imperiali, sentendosi partecipe della magnificenza dell'Impero.

Questo edonismo di Stato aveva una funzione di controllo sociale evidente. Un popolo soddisfatto nei suoi bisogni primari e intrattenuto quotidianamente era meno propenso a rivolte e sommosse. Le terme divennero così uno degli strumenti più efficaci di governo delle masse nella storia dell'urbanistica.

Il Mitreo sotterraneo e i culti orientali

Nei sotterranei delle Terme di Caracalla, tra le gallerie dove lavoravano gli schiavi e i servi addetti ai forni, è stato scoperto un Mitreo, un tempio dedicato al culto di Mitra. Questo ritrovamento testimonia la diffusione dei culti misterici orientali tra i ceti bassi e gli schiavi che operavano nelle viscere dell'edificio.

Il Mitraismo, religione di origine persiana che prometteva salvezza ultraterrena attraverso iniziazioni progressive, era particolarmente popolare tra soldati, schiavi e lavoratori. Il dio Mitra, rappresentato nell'atto di sacrificare un toro cosmico, offriva una speranza di riscatto spirituale a chi viveva in condizioni di durezza e sottomissione.

La presenza del Mitreo nei sotterranei delle terme crea un contrasto affascinante: mentre ai piani superiori i cittadini romani godevano dei piaceri offerti dall'imperatore, nelle gallerie sottostanti gli schiavi cercavano consolazione in culti che promettevano un'uguaglianza negata nella vita terrena. Questo dualismo riflette le contraddizioni profonde della società romana imperiale.

Le Terme di Caracalla rimasero in funzione fino al VI secolo d.C., quando i Goti tagliarono gli acquedotti durante l'assedio di Roma. Le rovine, spogliate dei marmi nei secoli successivi, conservano ancora oggi una maestosità che lascia senza fiato. Oggi ospitano rappresentazioni liriche estive, e i visitatori possono camminare tra quegli stessi ambienti dove duemila anni fa la plebe romana trovava momenti di piacere e dignità offerti da un imperatore che comprendeva il valore politico del benessere collettivo.

Di Alex (pubblicato @ 09:00:00 in Tecnologia, letto 29 volte)

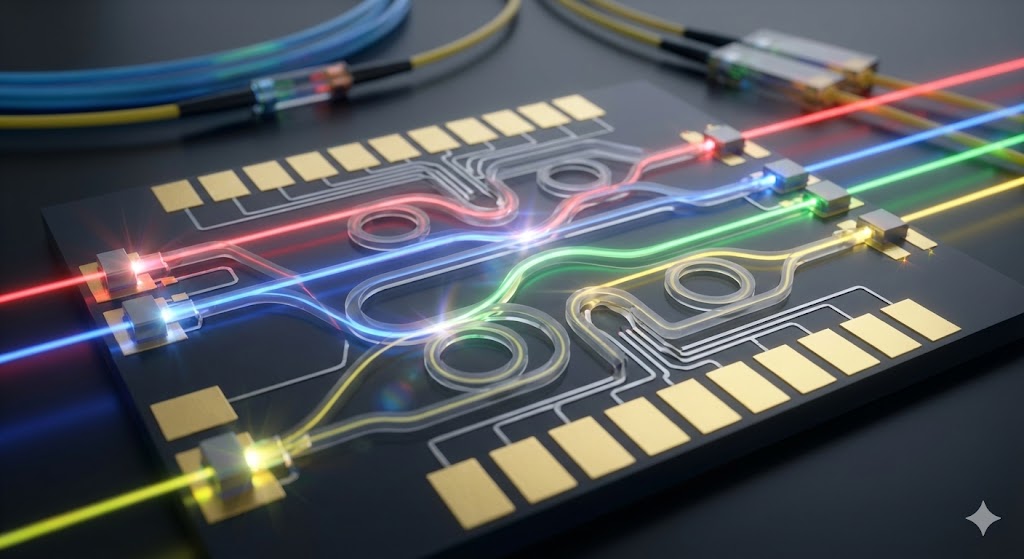

Chip fotonico fotonico con guide d'onda ottiche e fasci di luce colorati che attraversano circuiti integrati ottici al posto degli elettroni

I processori fotonici utilizzano fotoni invece di elettroni per eseguire calcoli, promettendo velocità della luce e latenza quasi zero. Questa rivoluzione tecnologica potrebbe trasformare l'intelligenza artificiale e le reti neurali profonde, superando i limiti fisici dell'elettronica tradizionale. LEGGI TUTTO L'ARTICOLO

Dalla fibra ottica ai processori di luce

La fotonica è la scienza che studia la generazione, manipolazione e rilevazione della luce, proprio come l'elettronica si occupa degli elettroni. Mentre la fibra ottica ha già rivoluzionato le telecomunicazioni trasmettendo dati attraverso impulsi luminosi, il calcolo fotonico rappresenta il passo successivo: utilizzare la luce non solo per trasportare informazioni, ma per elaborarle direttamente.

I processori fotonici sostituiscono i transistor elettronici con componenti ottici come guide d'onda, modulatori e risonatori che manipolano fasci di luce per eseguire operazioni logiche e aritmetiche. Invece di elettroni che fluiscono attraverso semiconduttori, i fotoni viaggiano attraverso strutture nanoscopiche di silicio o altri materiali, eseguendo calcoli alla velocità della luce letteralmente.

Questa transizione dalla materia carica alla luce neutra promette vantaggi straordinari. I fotoni non hanno massa né carica elettrica, quindi non soffrono delle stesse limitazioni fisiche degli elettroni: non generano calore significativo per attrito, non interferiscono elettromagneticamente tra loro, e possono viaggiare a velocità enormemente superiori con dispersione energetica minima.

Velocità della luce e latenza zero

Il vantaggio più evidente del calcolo fotonico è la velocità. Mentre gli elettroni in un chip di silicio viaggiano a una frazione significativa ma comunque limitata della velocità della luce, i fotoni in un chip fotonico si muovono effettivamente alla velocità della luce nel mezzo, circa 200.000 chilometri al secondo nel silicio.

Questa differenza si traduce in una riduzione drastica della latenza, il tempo che intercorre tra l'input di un dato e l'output del risultato. Per applicazioni che richiedono risposte in tempo reale, come il trading ad alta frequenza, i sistemi di controllo autonomi, o l'elaborazione di segnali radar, anche nanosecondi di latenza in meno possono fare una differenza cruciale.

Ma la vera rivoluzione non è solo la velocità puntuale, bensì la larghezza di banda. Un singolo fascio di luce può trasportare simultaneamente molteplici segnali a frequenze diverse attraverso la multiplazione a divisione di lunghezza d'onda. In pratica, centinaia di calcoli paralleli possono avvenire contemporaneamente attraverso la stessa guida d'onda ottica, moltiplicando esponenzialmente la capacità computazionale.

Efficienza energetica rivoluzionaria

Uno dei problemi più pressanti dell'informatica moderna è il consumo energetico. I data center che alimentano internet e l'intelligenza artificiale consumano già circa il due percento dell'elettricità mondiale, una percentuale destinata a crescere vertiginosamente con l'espansione dell'IA. Gran parte di questa energia viene dissipata come calore dai transistor elettronici.

I processori fotonici promettono un'efficienza energetica ordini di grandezza superiore. Poiché i fotoni non hanno carica elettrica, non generano calore resistivo quando viaggiano attraverso le guide d'onda. Le stime suggeriscono che i chip fotonici potrebbero consumare fino a 100 volte meno energia dei chip elettronici equivalenti per certe operazioni.

Questa efficienza diventa cruciale per l'addestramento di modelli di intelligenza artificiale, che richiede settimane di calcolo continuo su migliaia di GPU. Lightmatter, una startup di Boston, ha sviluppato processori fotonici specificamente per l'inferenza di reti neurali, dimostrando velocità superiori con una frazione del consumo energetico delle GPU tradizionali.

Intelligenza artificiale e reti neurali profonde

L'applicazione più promettente del calcolo fotonico è nell'intelligenza artificiale, in particolare nelle reti neurali profonde. Le operazioni fondamentali delle reti neurali sono moltiplicazioni matrix-vector e convoluzione, operazioni altamente parallelizzabili che si adattano perfettamente alla natura della fotonica.

Un chip fotonico può eseguire moltiplicazioni matriciali in un singolo passo utilizzando interferometri ottici programmabili. Invece di migliaia di cicli di clock per moltiplicare matrici grandi, la luce attraversa il chip una volta sola, e l'interferenza costruttiva e distruttiva dei fasci luminosi produce automaticamente il risultato. Questa è elaborazione analogica ottica: il calcolo avviene fisicamente attraverso la propagazione della luce.

Aziende come Lightelligence del MIT e Luminous Computing stanno sviluppando acceleratori fotonici per deep learning che promettono di addestrare modelli di linguaggio grande e reti neurali convoluzionali con velocità e efficienza senza precedenti. I primi prototipi hanno dimostrato prestazioni impressionanti su compiti di riconoscimento immagini e elaborazione del linguaggio naturale.

Le sfide dell'integrazione fotonica

Nonostante il potenziale rivoluzionario, il calcolo fotonico affronta sfide tecniche significative. La principale è l'integrazione: mentre i chip elettronici beneficiano di decenni di miniaturizzazione che hanno portato a transistor di pochi nanometri, i componenti fotonici sono limitati dalla lunghezza d'onda della luce, tipicamente centinaia di nanometri.

Questo significa che i chip fotonici tendono a essere fisicamente più grandi dei chip elettronici con capacità equivalente. Inoltre, convertire segnali elettrici in ottici e viceversa richiede componenti optoelettronici che introducono inefficienze. Laser, modulatori e fotodetector devono essere integrati sul chip, complicando la produzione.

Un'altra sfida è la memoria. Mentre esistono memorie elettroniche estremamente dense e veloci, la memoria ottica è ancora in fase sperimentale. La maggior parte dei sistemi fotonici attuali utilizza ancora memoria elettronica, creando un collo di bottiglia nell'architettura ibrida ottico-elettronica.

Il software rappresenta un ostacolo aggiuntivo. Gli algoritmi e i framework di programmazione sono stati ottimizzati per decenni per architetture elettroniche. Ripensare algoritmi per sfruttare appieno il parallelismo analogico della fotonica richiede un cambio di paradigma significativo nella programmazione.

Applicazioni emergenti e futuro

Oltre all'intelligenza artificiale, il calcolo fotonico trova applicazioni in campi dove velocità e larghezza di banda sono critici. Nei data center, interconnessioni fotoniche stanno già sostituendo collegamenti elettrici per comunicazioni ad altissima velocità tra server. Cisco, Intel e altre grandi aziende stanno investendo pesantemente in switch ottici che eliminano la conversione ottico-elettronica.

Nel campo delle telecomunicazioni 6G, previste per il 2030, la fotonica sarà essenziale per gestire le velocità di trasmissione terabit richieste. Nel calcolo quantistico, piattaforme fotoniche come quelle di Xanadu utilizzano stati quantistici della luce per implementare qubit, offrendo un'alternativa agli approcci con ioni intrappolati o superconduttori.

Applicazioni di nicchia ma critiche includono la crittografia quantistica basata su fotoni per comunicazioni ultra-sicure, il LIDAR fotonico per veicoli autonomi che richiede elaborazione in tempo reale di enormi quantità di dati sensoriali, e simulatori ottici per problemi di ottimizzazione complessi.

Il calcolo fotonico si trova oggi in una fase simile all'elettronica degli anni Cinquanta: le possibilità teoriche sono chiare, i primi dispositivi funzionanti esistono, ma la tecnologia deve ancora maturare per applicazioni commerciali su larga scala. Tuttavia, con investimenti massicci da parte di giganti tecnologici e startup innovative, e con la pressione crescente per superare i limiti energetici e di velocità dell'elettronica, i prossimi dieci anni potrebbero vedere la luce diventare il nuovo elettrone nel cuore dei nostri computer.

Di Alex (pubblicato @ 07:00:00 in Nuove Tecnologie, letto 73 volte)

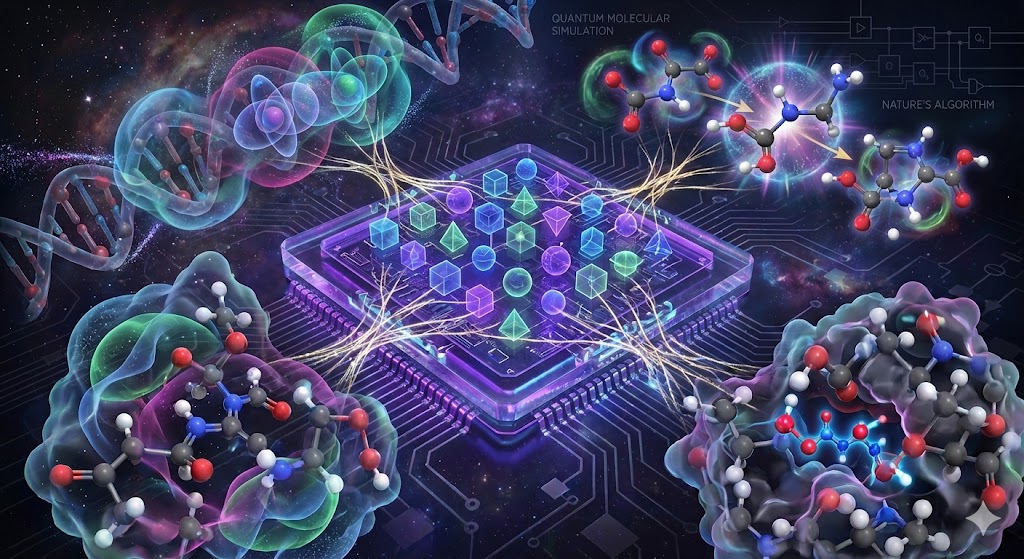

Visualizzazione artistica di un computer quantistico con qubit sovrapposti che simulano interazioni molecolari e strutture chimiche quantistiche

Oltre la crittografia e gli algoritmi teorici, il vero potenziale rivoluzionario dei computer quantistici risiede nella simulazione della natura. La chimica quantistica e la scoperta di nuovi farmaci e materiali richiedono calcoli impossibili per i computer classici, ma naturali per le macchine quantistiche. LEGGI TUTTO L'ARTICOLO

Simulare la natura con la meccanica quantistica

Richard Feynman, premio Nobel per la fisica, osservò negli anni Ottanta che simulare sistemi quantistici con computer classici è intrinsecamente inefficiente. La natura opera secondo le leggi della meccanica quantistica, e per simularla accuratamente servono computer che sfruttano gli stessi principi quantistici. Questa intuizione è diventata la motivazione fondamentale per lo sviluppo dei computer quantistici.

Mentre la crittografia quantistica e l'algoritmo di Shor per fattorizzare numeri grandi hanno catturato l'attenzione pubblica, la simulazione molecolare rappresenta probabilmente l'applicazione più trasformativa del quantum computing. Molecole, materiali e reazioni chimiche sono governati da interazioni quantistiche tra elettroni e nuclei atomici, interazioni che diventano esponenzialmente complesse da calcolare all'aumentare del numero di particelle.

Un computer classico deve considerare tutte le possibili configurazioni degli elettroni in una molecola, un numero che cresce esponenzialmente. Per una molecola con appena 50 elettroni, le configurazioni possibili superano il numero di atomi nell'universo osservabile. Un computer quantistico, invece, può rappresentare questi stati sovrapposti naturalmente nei suoi qubit, riducendo drasticamente la complessità computazionale.

Drug discovery: dalla provetta al qubit

Lo sviluppo di nuovi farmaci è un processo estremamente costoso e dispendioso in termini di tempo. Portare un nuovo farmaco sul mercato richiede in media oltre un decenno e costi che superano il miliardo di dollari. Gran parte di questo tempo e denaro è speso nel trial and error: testare migliaia di composti sperando che uno si leghi al bersaglio biologico desiderato.

I computer quantistici promettono di rivoluzionare questo processo simulando precisamente come le molecole farmacologiche interagiscono con le proteine bersaglio nel corpo umano. Invece di sintetizzare e testare fisicamente migliaia di composti, i ricercatori potrebbero simulare queste interazioni in silico, o meglio, in qubit, identificando i candidati più promettenti prima ancora di entrare in laboratorio.

Aziende farmaceutiche come Roche, Biogen e Boehringer Ingelheim stanno già collaborando con compagnie di quantum computing come IBM, Google e IonQ per esplorare queste applicazioni. Nel 2020, Google ha dimostrato la simulazione di una reazione chimica semplice sul suo processore quantistico Sycamore, un primo passo verso simulazioni molecolari più complesse.

Le simulazioni quantistiche potrebbero accelerare la scoperta di antibiotici per combattere la resistenza antimicrobica, sviluppare farmaci personalizzati basati sul genoma individuale, e progettare terapie per malattie rare che oggi non sono economicamente convenienti da studiare con metodi tradizionali.

Materiali avanzati e catalizzatori

Oltre ai farmaci, la simulazione quantistica può rivoluzionare la scienza dei materiali. La progettazione di nuovi materiali con proprietà specifiche, come superconduttori ad alta temperatura, batterie più efficienti, o catalizzatori per produrre carburanti puliti, richiede una comprensione profonda delle interazioni elettroniche a livello quantistico.

Il processo Haber-Bosch per produrre ammoniaca dai fertilizzanti, cruciale per l'agricoltura globale, consuma circa il due percento dell'energia mondiale. Trovare un catalizzatore migliore potrebbe ridurre drasticamente questo consumo energetico, ma progettare catalizzatori richiede simulare interazioni quantistiche complesse tra molecole di azoto, idrogeno e superfici metalliche.

I computer quantistici potrebbero simulare migliaia di potenziali catalizzatori in settimane, identificando configurazioni atomiche ottimali che i chimici impiegherebbero decenni a scoprire sperimentalmente. Questo approccio è già stato applicato da ricercatori di Microsoft e Google che hanno simulato la fissazione dell'azoto, il primo passo verso catalizzatori più efficienti.

Altre applicazioni promettenti includono la progettazione di celle solari più efficienti simulando il trasferimento di elettroni nei materiali fotovoltaici, lo sviluppo di batterie allo stato solido con maggiore densità energetica, e la scoperta di nuovi magneti permanenti che non richiedono terre rare.

L'algoritmo variazionale quantistico

Gli algoritmi più promettenti per la simulazione chimica quantistica sono i Variational Quantum Eigensolvers e i Quantum Approximate Optimization Algorithms. Questi algoritmi ibridi combinano processori quantistici con computer classici, sfruttando i punti di forza di entrambi.

Il VQE prepara uno stato quantistico sul processore quantistico, misura l'energia del sistema, e usa un computer classico per ottimizzare i parametri dello stato quantistico iterativamente. Questo approccio è particolarmente adatto ai computer quantistici NISQ, i dispositivi quantistici a scala intermedia rumorosa disponibili oggi, che hanno un numero limitato di qubit e soffrono di errori.

Ricercatori hanno già usato il VQE per calcolare l'energia dello stato fondamentale di molecole semplici come l'idruro di litio e l'acqua con precisione competitiva rispetto ai metodi classici. Man mano che i processori quantistici migliorano, molecole progressivamente più grandi e complesse diventeranno simulabili.

Sfide e prospettive temporali

Nonostante il potenziale straordinario, la simulazione molecolare quantistica utile rimane una sfida formidabile. I computer quantistici attuali hanno troppi pochi qubit e troppi errori per simulare molecole di rilevanza farmacologica o industriale. Molecole biologicamente interessanti come le proteine richiedono centinaia o migliaia di qubit logici privi di errori.

La correzione degli errori quantistici è essenziale ma costosa: ogni qubit logico richiede centinaia o migliaia di qubit fisici per implementare i codici di correzione degli errori. I processori quantistici attuali hanno da decine a poche centinaia di qubit, ancora lontani dai milioni necessari per simulazioni veramente utili.

La maggior parte degli esperti prevede che computer quantistici praticamente utili per la chimica computazionale emergeranno tra 5 e 15 anni. Nel frattempo, algoritmi migliorati e hardware quantistico in rapido progresso continuano a spingere i confini di ciò che è simulabile.

Quando finalmente i computer quantistici raggiungeranno la maturità, permetteranno di simulare la natura stessa, aprendo prospettive rivoluzionarie per medicina, energia e materiali. La capacità di progettare molecole e materiali al computer, prevedendone accuratamente le proprietà prima della sintesi, trasformerà la chimica da scienza sperimentale a scienza predittiva, accelerando l'innovazione in modi oggi difficilmente immaginabili.

Fotografie del 19/01/2026

Nessuna fotografia trovata.

Think different!

Think different!

Microsmeta Podcast

Microsmeta Podcast Feed Atom 0.3

Feed Atom 0.3

(p)Link

(p)Link Commenti

Commenti Storico

Storico Stampa

Stampa